Table of Contents

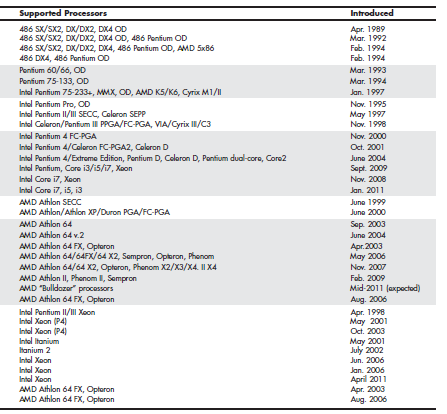

Montaje y reparación de equipos informáticos

Componentes para el ensamblaje

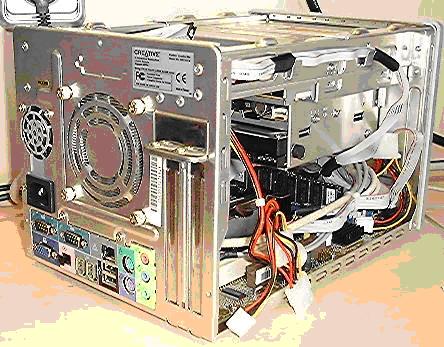

Chasis

El Chasis de un ordenador es el armazón, normalmente de aluminio o de plástico, que contiene todos los elementos del ordenador. Se conoce también con el nombre de caja o torre, por ser el diseño de chasis más conocido en los últimos años. Es muy habitual adquirir junto con el chasis la fuente de alimentación por lo que normalmente son elementos indivisibles aunque es habitual y muy sencillo sustituir la fuente de alimentación por otra más potente, por ejemplo

Caja

La caja suele hacer referencia a lo que es la carcasa, que puede ser de muy variados tamaños y formas. Los más conocidos son:

- Torre: La caja es alargada y se coloca de forma vertical. Dependiendo del tamaño de ésta podrá contener más o menos bahías de 5 1/4 y 3 1/2 . Actualmente quizás el modelo de caja más extendido

- Minitorre: De diseño similar a las cajas de torre pero de menor tamaño. Dispone, por tanto, de menor número de bahías de ambos tipos

- Sobremesa: De tamaño similar a una torre pero en esta ocasión la caja se dispone de forma horizontal

- Barebone: Es una caja de tamaño muy reducido cuyo propósito es ocupar poco espacio y tener un diseño algo más llamativo

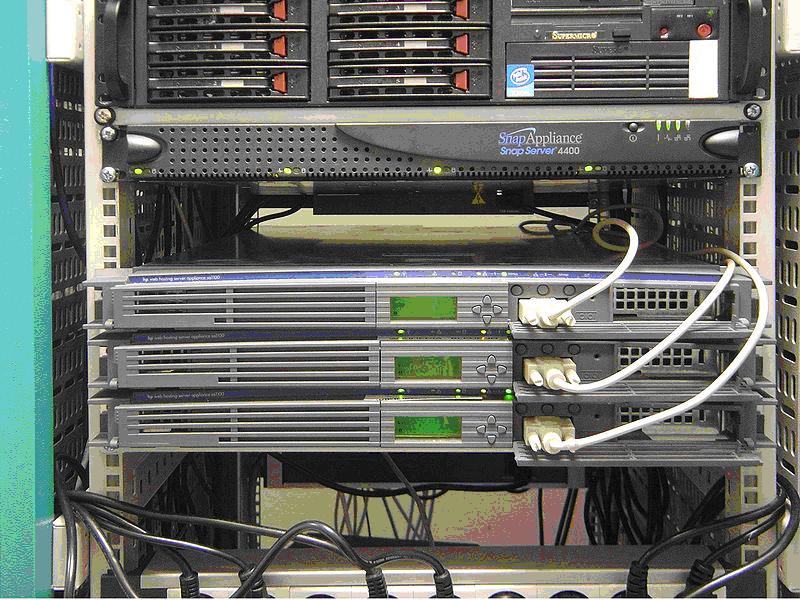

- Rack: También conocidos como armarios o bastidores, pueden almacenar un número muy alto de equipos en un formato conocido como U, que define la altura de dicho equipo. En este caso los equipos (1U, 2U, 4U) van atornillados al armario permitiendo alojar un gran número de servidores en un espacio reducido. Utilizado principalmente en Centros de Procesos de Datos (CPD)

Alimentación

La alimentación se proporciona a todo el equipo informático a través de lo que se conoce como Fuente de Alimentación que va atornillada en la caja. A esta fuente estarán conectados suficientes cables para alimentar a los dispositivos que lo necesiten, que normalmente serán aquellos que no van conectados directamente a la placa base, así como para alimentar a la placa base que suministra la corriente necesaria a casi todos los dispositivos que se conectan a ella. Como excepción a este caso se pueden citar las tarjetas gráficas que en la actualidad necesitan más alimentación de la que les proporciona la placa base a través del conector correspondiente y deben conectarse en algunos casos directamente a la fuente de alimentación.

Actualmente es muy común disponer de fuentes de alimentación con una potencia desde 500 W para un equipo de sobremesa hasta 1000 W aprox. para equipos que requieran potencia adicional (gaming, por ejemplo), en la mayoría de ocasiones por las exigencias que actualmente tienen las tarjetas gráficas, o bien dependiendo del número de componentes que queramos conectar.

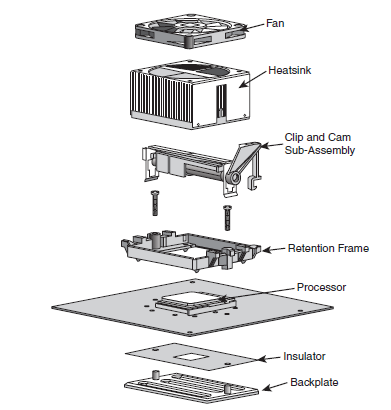

Refrigeración

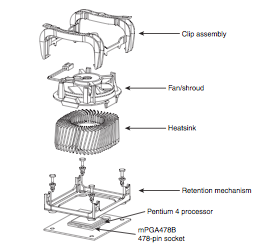

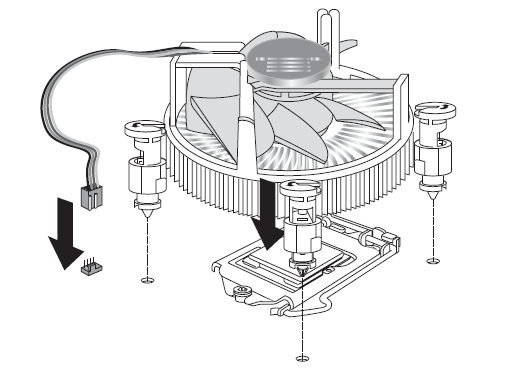

El sistema de refrigeración del sistema informático lo componen todos los dispositivos cuya finalidad es reducir la temperatura del conjunto o de algunos componentes de forma más específica:

- Los disipadores del procesador y los puentes norte y sur son los elementos de refigeración que se conocen como disipación pasiva

- Los ventiladores, colocador siempre sobre un disipador, en el procesador, el puente norte y en diferentes zonas de la caja con la finalidad de refrigerar estos componentes o bien sacar el aire caliente de la parte interna de la caja. En el caso de los ventiladores, algunos aspectos a tener en cuenta son el ruido (medido en dB) y la velocidad de giro (medido en rpm), que normalmente será variable en función de la necesidad de refrigeración del equipo

- Heat-pipes ó tuberías de calor, consisten en tubos huecos con un fluido dentro que absorbe el calor generado por el procesador y cuando el fluído de evapora por el aumento de temperatura se condensa y vuelve a estar frío para absorber de nuevo más calor generador

Estos sistemas de refrigeración han ido evolucionando en la misma medida que los propios componentes del ordenador, puesto que un mayor rendimiento suele venir acompañado de un incremento en la temperatura y se han tenido que diseñar elementos capaces de disipar unas temperatura que cada vez son más elevadas.

Por lo general, podemos utilizar, para un mismo equipo, varios ventiladores de forma que utilicemos ventiladores en la partebaja de la caja para introducir aire frío, alguno en la parte lateral para renovar el aire que lleva tanto a la tarjeta gráfica o CPU y, por último, podemos colocar ventiladores en la parte trasera que será los encargados de extraer el aire caliente de la caja. No siempre contaremos con todos ellos en todas las configuraciones de caja ya que siempre dependerá de las exigencias en cuanto a refrigeración de cada montaje concreto. Todo esto contando siempre con un ventilador (y el correspondiente disipador) dedicado en exclusiva a refrigerar el procesador y otro incorporado en la propia tarjeta gráfica refrigerandola también en exclusiva.

En cualquier caso, tendremos que prestar mucha atención a la limpieza a de todos los ventiladores con los que cuente nuestra caja ya que serán los elementos de la misma que más suciedad atraigan, hasta el punto de poder quedar totalmente taponados y dejar de cumplir totalmente con su función.

En el caso de los portátiles, por lo general cuentan con un ventilador situado cerca del procesador que se encarga de hacer circular aire por un sistema de canalización de forma que este aire (ya caliente) se retire por una lateral (generalmente) al exterior. Además, algunas partes suelen refrigerarse a través de heat-pipes que comunican con la zona del ventilador.

Actualmente también podemos encontrar equipos con refrigeración líquida, aunque no está muy extendido su uso hay empresas que ofrecen productos comerciales. Ventajas de este tipo de refrigeración son la ausencia de ruido y la posibilidad de trabajar con procesadores más potentes y overclocking puesto que se puede conseguir temperaturas más bajas. En este caso lo habitual es refrigerar mediante líquido solamente el procesador puesto que es el componente que más calor genera.

Procesador

Introducción

El procesador o microprocesador es una de las partes fundamentales en cualquier equipo informático. Es el encargado de ejecutar cada una de las instrucciones que forman cualquier programa que se encuentre en ejecución. De él depende, en gran medida (aunque no toda), el rendimiento general del sistema, puesto que a mayor velocidad de proceso más instrucciones se ejecutarán por unidad de tiempo y, por tanto, más rápido se ejecutarán los programas.

La velocidad de un procesador se mide en Hercios (GHz actualmente) que mide el número de ciclos a los que opera el procesador. Para determinar la velocidad real del procesador es necesario conocer además cuantas operaciones puede éste ejecutar en un ciclo. Esta medida dependerá en gran medida de la tecnología utilizada pero se puede decir que actualmente un procesador es capaz de ejecutar entre 3 y 4 instrucciones por ciclo, y algunas más en el caso de procesadores multinúcleo. Por tanto, a misma frecuencia es posible que un procesador sea mucho más eficiente que otro. Sólo hay que observar como procesadores actuales operan a frecuencias más bajas que procesadores con unos cuantos años de antigüedad y sin embargo los primeros ofrecen un rendimiento mucho mayor que los segundos. Eso se debe a que ahora otras características del procesador están cobrando mucha importancia y afectan directamente al rendimiento del mismo, como son la tecnología multicore y el aumento de la memoria caché del procesador en los últimos años.

Desde hace ya un tiempo el diseño de procesadores se ha centrado en 4 ideas:

- Incrementar el número de transistores y la densidad de estos (haciendo cada vez más pequeño su tamaño), lo que se conoce como aumentar la escala de integración (actualmente en 22 nm)

- Incrementar la velocidad del reloj (actualmente en torno a los 3 GHz)

- Incrementar el tamaño de los registros internos (actualmente 64 bits)

- Incrementar el tamaño del número de núcleos (actualmente sobre 6-12)

Así, la información más relevante de un procesador es la siguiente:

- Velocidad del reloj: Velocidad interna del procesador

- Velocidad del bus: Velocidad con la que el procesador se comunica con la placa base

- Memoria caché: Utilizada para almacenar los datos más usados por el procesador. Siempre hay que tener en cuenta de que tipo de caché se trata (L1, L2, L3), puesto que determinan la cercanía al procesador y su velocidad

- Número de núcleos: Permiten replicar algunas partes del procesador por lo que algunas tareas pueden realizarse de manera concurrente

- Hyperthreading (sólo Intel): Tecnología de Intel que permite que los programas preparados para ejecutar hilos lo hagan de forma paralela en un solo procesador

- Consumo: Medido en vatios, actualmente cobra mucha importancia en portátiles y netbooks, puesto que influye directamente en el consumo y duración de la batería

Tecnologías

Y en cuanto a las tecnologías que mejoran los procesadores en la actualidad, estas son algunas de las más importantes.

SMM (System Management Mode)

Surgió ante la necesidad de añadir la capacidad de gestionar la energía en ordenadores portátiles en el año 1990. Este modo de operación permite gestionar la energía a bajo nivel y controlar el hardware de forma transparente al Sistema Operativo. Con el tiempo se le fueron añadiendo más funcionalidades y actualmente en los ordenadores modernos incluye mas funcionalidades, entre las que destacan las siguientes:

- Funciones ACPI (Advanced Configuration and Power Interface) y APM (Advanced Power Management) para la gestión avanzada del sistema

- Soporte para versiones heredadas de USB (USB legacy), que permite usar dispositivos como ratón y teclado USB en sistemas que no soportan este bus

- Monitorización del sistema (Temperatura, velocidad ventiladores)

- WOL (Wake On LAN)

MMX

MMX (Multimedia Extensions) fue tecnología introducida en los primeros procesadores Pentium de Intel que mejoraba los procesadores con instrucciones dedicadas a manipular y procesar video, audio y gráficos de una forma más eficiente. Surgen como respuesta a la aparición de las primeras aplicaciones multimedia en los PC. Con el tiempo serían sustituidas por la tecnología SSE.

SSE

SSE (Streaming SIMD Extensions, 1999) es una tecnología que sustituye a MMX incorporando nuevas instrucciones que mejoran el rendimiento de aplicaciones de gráficos avanzados, 3D, audio y video streaming y reconocimiento de voz. Con el tiempo esta tecnología ha ido mejorando con SSE2, SSE3 y SSE4 que han ido adoptando los sucesivos modelos de Intel.

3DNow!

3DNow! es una tecnología desarrollada por AMD como alternativa a las instrucciones SSE de Intel.

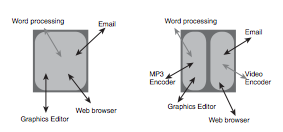

HyperThreading (HT)

La tecnología HT (Hyper Threading, 2002) permite a un procesador convertirse en dos procesadores virtuales puesto que es capaz de manejar dos conjuntos de instrucciones al mismo tiempo de forma que, aunque ambos hilos de ejecución comparten la memoria caché, es capaz de mejorar el rendimiento de las operaciones ejecutadas (sobre el 25%) en contextos multitarea y aplicaciones multihilo.

Multicore

La tecnología multicore permite disponer de varias unidades de procesamiento en un solo procesador, de forma que el rendimiento global se aprovecha de esa situación a un coste moderado.

Esta tecnología fue introducida tanto por Intel como AMD en procesadores de escritorio en 2005 con el Pentium D y el Athlon 64 X2, respectivamente.

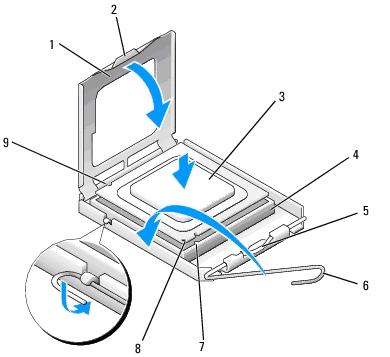

Zócalo

El zócalo es el elemento de la placa base donde se conecta el procesador, permitiendo asi la conexión con el resto de componentes del ordenador. Actualmente se están usando dos tipos de zócalos:

- 478: Utilizado para los modelos Pentium 4 y Celeron 4

- LGA775: Utilizado para los modelos Core 2 Duo y Quad, las últimas versiones de Pentium 4, los modelos Pentium D y algunas versiones de Celeron D

- LGA1156: Utilizado por la serie i3/i5/i7 de Intel, las series Nehalem y Westmere. A partir de ahora el Puerte Norte del chipset se integra con el procesador. Así, el socket se diseña para conectar el procesador con el PCH (Platform Controller Hub), que es lo que antes se conocía como Puerte Sur. Se incluyen entonces las siguientes tecnologías en este socket: PCI Express x16, DMI, y controlador de memoria DDR3 con doble canal

- LGA1366, Socket B: Utilizado para modelos i7 y Xeon de Intel. Incluye QPI y controlador de memoria DDR3 de triple canal

- LGA1155, Socket H2: Utilizado para la segunda y tercera generación de los modelos i3/i5/i7 de Intel, las series Sandy Bridge e Ivy Bridge

- LGA1150 o Socket H3: Utilizado para la cuarta y quinta generación de procesadores de Intel, las series Haswell y Broadwell respectivamente

- LGA1151: Utilizado para la sexta generación de los procesadores de Intel, la serie Skylake

- LGA2011 v3: Utilizado en el último modelo i7 (Extreme Edition) y para los modelos de servidor (Xeon)

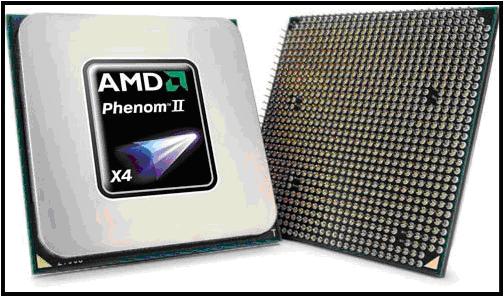

- AM2 y AM2+: Utilizado por AMD en los modelos Athlon 64, Athlon 64 FX y Athlon 64 X2

- AM3 y AM3+: Utilizado por AMD para modelos Athlon II X2/X3/X4, Phenom II X2/X3/X4/X6, la serie FX (Bulldozer y Piledriver) y algunos modelos de Sempron

- FM2: Utilizado por la serie (APUs) A4, A6, A8 y A10 de Piledriver

- Socket F: Utilizado por AMD (2006) para su línea de procesadores de servidor Opteron.

Modelos actuales Intel

Pentium 4

Modelo intrucido en el año 2000 con las siguientes características:

- Velocidad entre 1.3GHz y 3.8 GHz

- FSB a 400MHz - 1066 MHz

- Tecnología HT

- Hasta 2MB de caché

- Tecnología SSE2

Pentium D, Pentium Extreme Edition

Aparecen en el año 2005 introduciendo el primer modelo multicore de Intel, concretamente un procesador dual-core, con hasta 4MB de caché.

Core 2 Duo / Quad

Aparecen en el año 2006 y suponen un cambio de arquitectura proporcionando sobre un 40% más de rendimiento y haciendo hincapié en el ahorro de energía. La serie Duo disponía de 2 cores y la serie Quad de 4 cores. Suponen el cambio a arquitecturas de 64 bits por parte de Intel.

Serie i

El primer procesador de la serie i (concretamente un i7) aparecen en 2008. Nueva arquitectura de Intel, en la que aparecen al mismo tiempo tres modelos: i3, i5, i7; según el rendimiento que ofrecen. Los modelos i3 para un rendimiento bajo, modelos i5 para un rendimiento medio y la serie i7 para rendimientos superiores. Su principal diferencia será el número de cores y la memoria caché.

Hasta el momento se han sucedido ya hasta 6 generaciones de la serie i: Nehalem, Sandy Bridge, Ivy Bridge, Haswell, Broadwell y Skylake.

Celeron

El modelo Celeron de Intel se identifica siempre con el modelo de bajo coste y rendimiento de la familia Intel. Se comenzó a comercializar como el modelo de bajo coste de los Pentium 4 y se ha seguido manteniendo como modelo de bajo coste de los modelos actuales de Intel. Por eso, aunque mantenga el mismo nombre, los modelos actuales de Celeron nada tienen que ver con los primeros modelos Celeron.

Modelos actuales AMD

Athlon 64

Aparecen en 2003 como los primeros procesadores basados en arquitectura de 64 bits de AMD para ordenadores de escritorio.

Athlon X2, Athlon 64 X2

Aparecen en el año 2005 como los primeros procesadores multicore (2 cores) de AMD. Su diseño permitía a los usuarios cambiar su modelo Athlon 64 por este modelo sin tener que cambiar la placa base, lo que era una ventaja para su implantación.

Phenom, Phenom II

Nueva arquitectura de AMD, que aparece en el año 2007, con modelos de procesadores de hasta 6 cores y soporte para memoria DDR3, aunque los primeros modelos incluían soporte para DDR2.

AMD APU, serie A (antes AMD Fusion)

Los modelos AMD Fusion incluyen varias series de procesadores móviles, de escritorio y servidor. La serie C (para netbooks) y la serie E (para portátiles y escritorio de bajo coste). Además, la serie Bulldozer abarca procesadores para escritorio de alto rendimiento. Lo que se conoce como los modelos FX, de hasta 8 núcleos.

Las series C y E se centrán en el desarrollo de lo que se conoce como APU (Advanced Processing Unit) que permite incluir en el mismo encapsulado a CPU y GPU (Graphical Processing Unit) de forma que se consigue un mayor rendimiento y un menor consumo, centrando su desarrollo en la fabricación de procesadores para netbooks y portátiles y ordenadores de escritorio de bajo consumo.

AMD FX

Actualmente la gama de procesador AMD que ofrece un mayor rendimiento, llegando a alcanzar cifras de hasta 4.7 Ghz, 8 núcleos y 8 MB de memoria caché L3.

Duron, Sempron

En el año 2000 los modelos Duron eran los modelos de bajo coste de los procesadores actuales de AMD. Más adelante, en el año 2004 (y hasta la actualidad) pasaron a denominarse Sempron al modelo de bajo coste de AMD con el objetivo de competir con los modelos Celeron D de Intel.

Overclocking

El overclocking es una forma de aumentar la velocidad del procesador aprovechando que, normalmente, los fabricantes de procesadores fijan como velocidades de los modelos que comercializan unos valores dentro de un rango de seguridad. Eso significa que realmente el procesador es capaz de funcionar a una velocidad mayor, de forma que es posible, mediante overclocking, acercar la velocidad de dicho procesador a su velocidad máxima soportada. De esa manera es posible conseguir entre un 10% y un 20% más de rendimiento.

Esta técnica se aplica normalmente a procesadores, pero puede ser aplicada también a otros dispositivos del sistema como memoria, tarjeta gráfica y buses. En cualquier caso habrá que tener en cuenta que al hacer funcionar el dispositivo a una velocidad mayor, éste se calentara más, por lo que es necesario mejorar el sistema de refrigeración si empleamos esta técnica para mejorar el rendimiento de nuestro sistema.

En algunos casos, como ocurre con algunos modelos de AMD (Phenom II y Athlon II) es posible utilizar esta técnica desbloqueando núcleos que se encuentran deshabilitados por diversas razones:

- Que un modelo X4 pueda ser vendido como X3 y que el núcleo desbloqueado pueda funcionar sin problemas

- Que algún núcleo pueda tener algún problema y sea bloqueado por esa razón, de forma que desbloquearlo no lo haga funciona correctamente

- Que algún núcleo pudiera dar problemas más serios y se haya bloqueado por esa razón. Es posible que desbloqueándolo la placa base o el procesador dejen de funcionar

Placa Base

La placa base o placa madre (motherboard en inglés) es una tarjeta de circuito impreso de tamaño variable (depende del formato de ésta) donde se conectan todas las partes de un equipo informático. Además, tiene ya instalados algunos circuitos entre los que cabe destacar el chipset, la BIOS, los controladores para los periféricos que ésta soporte y, actualmente, algunos periféricos como tarjetas gráficas y tarjetas de red ya forman parte de la placa. También incorpora conectores para el procesador, la memoria RAM, discos duros, unidades de almacenamiento y un conjunto de periféricos soportados.

Aunque gran parte de los dispositivos deben conectarse a ella es muy importante una buena elección de placa base. De ella depende la velocidad del FSB (Front Side Bus) o bus principal, actualmente reemplazado por DMI (Direct Media Interface) y QPI (QuickPath Interconnect) en Intel e HyperTransport en AMD, que determinará la velocidad del bus que comunica los principales componentes del sistema entre ellos. Dependiendo también del chipset incluido tendrá soporte para unas u otras tecnologías (USB 2.0, USB3.0, . . .). Además, los puente norte y sur incluidos en la placa se comunican entre sí y comunican las ranuras de expansión con la memoria y la CPU (ver esquemas de placas base del Bloque 1). Es, por tanto, una parte muy importante a la hora de elegir un equipo pero sin embargo muy poco tenido en cuenta por estrategias de marketing.

Entre las características de una placa base, hay que destacar las siguientes:

- Zócalo del procesador: Determina que modelos de procesadores podremos conectar

- Tipo/cantidad de memoria RAM soportado: Determina que tecnología de memoria (DDR/DDR2/DDR3/…) puedo conectar y cuanta cantidad de ésta soporta la placa base. También vendrá muy determinado por el procesador utilizado, puesto que éste también deberá soportar dicho tipo de memoria

- Chipset: Determina en gran parte las tecnologías soportadas por la placa y por tanto el rendimiento global de la misma

- Puertos de expansión: Tipo y cantidad de puertos de expansión de los componentes con los que podré aumentar las capacidades de mi equipo

- Formato: Tamaño y propósito de la placa base, del que hablaremos un poco más adelante

- Componentes integrados: Actualmente las placas base integran algunos componentes que tiempo atrás eran menos importantes pero que ahora se consideran imprescindibles, como pueden ser la tarjeta de red, tarjeta gráfica, tarjeta de sonido, controladora RAID, . . .

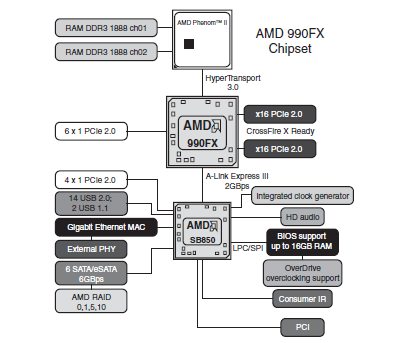

Chipset

El chipset es la característica que define a la placa base. Definirá toda la tecnología soportada por la misma por lo que se considera el parámetro más importante a la hora de decidir la adquisición de una nueva placa base. Del chipset depende como se interconectan todas las partes del equipo con el procesador. El modelo de chipset puede determinar la velocidad del FSB (bus que conectar el procesador con el resto del sistema), la tecnología de memoria RAM soportada (DDR, DDR2 ó DDR3, por ejemplo), la tecnología empleada en buses de entrada/salida como discos, USB, PCI-Express, . . . y el disponer de algunos componentes integrados como tarjeta gráfica, tarjeta de red y tarjeta de sonido, entre otros.

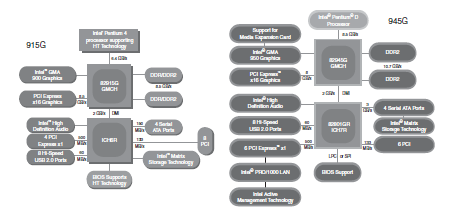

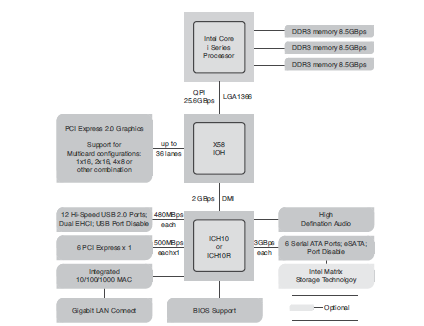

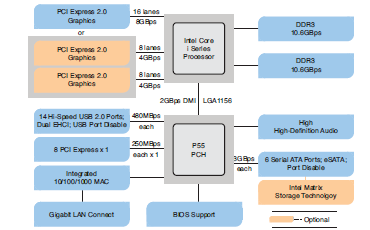

En cuanto a la arquitectura del chipset, en los últimos años se puede hablar de dos tendencias:

- Arquitectura Hub: El chipset de la placa se reparte entre dos componentes, conocidos como puente norte y puente sur. El puente norte se encarga de interconectar al procesador con los componentes más rápidos del sistema (memoria RAM y gráficos) y el puente sur interconecta el puente norte con el resto de componentes y buses del sistema (PCI, red, audio, discos, . . .). Está arquitectura venía a sustituir a la tradicional arquitectura conocida como puente norte/puente sur (North Bridge/South Bridge)

- PCH, Platform Controller Hub: En esta nueva arquitectura, utilizada desde 2008, el procesador incorpora el puente norte incluyendo controlador PCI Express (para gráficos), DMI ó QPI (Bus de conexión con el nuevo puente sur) y controlador de memoria DDR3. Al puente sur se le conoce como PCH y gestiona la interconexión del procesador con el resto de componentes del sistema a través del FSB (ahora conocido como DMI o QPI). En este caso, el chipset se ve reducido a tan sólo lo que antes se conocía como puente sur, puesto que toda la funcionalidad del antiguo puente norte la asume el procesador

A continuación, se muestra la estructura de los chipset para algunos modelos de placas base para Pentium 4 y modelos de la serie i de Intel, y para la serie Phenom II de AMD.

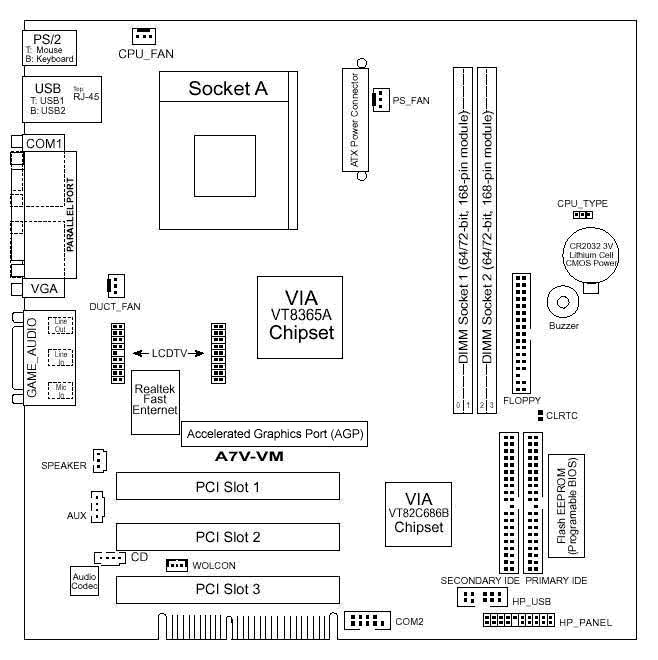

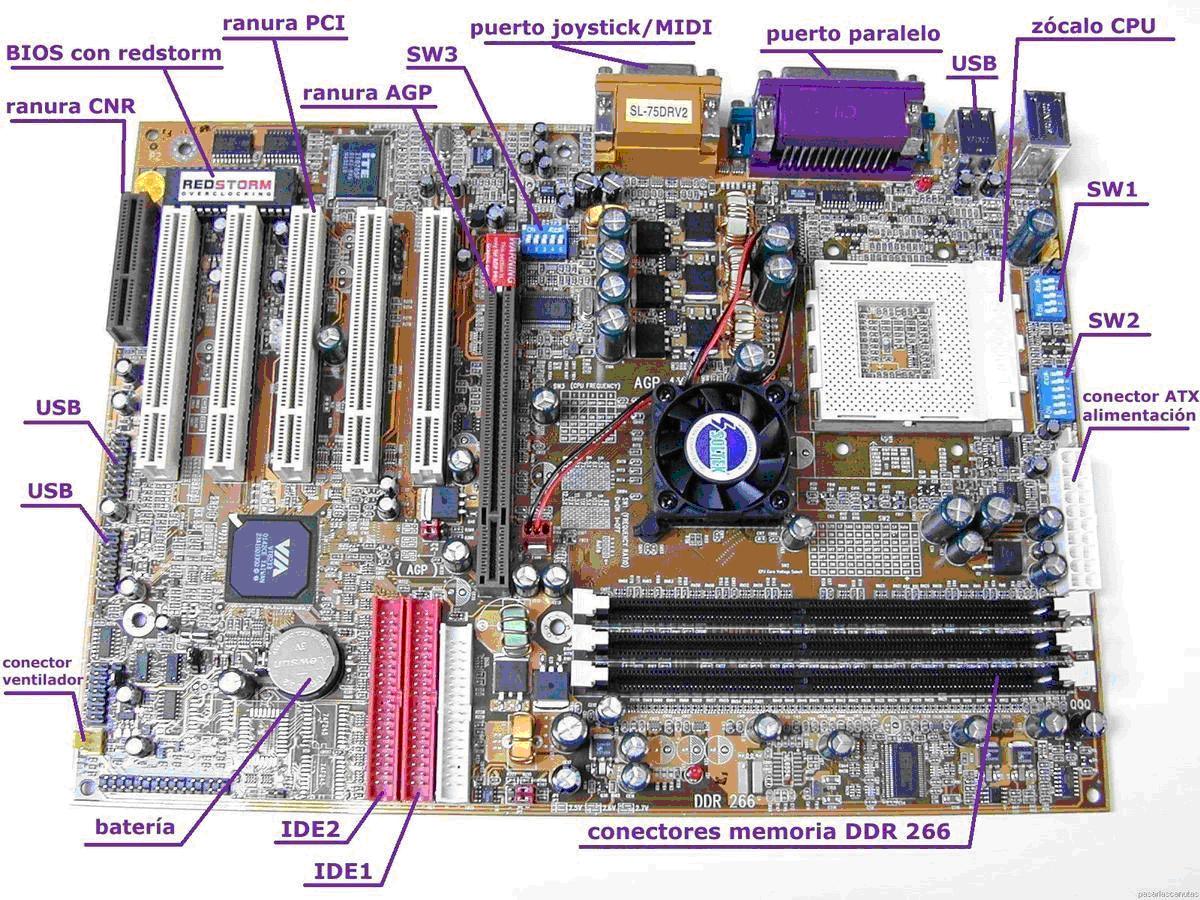

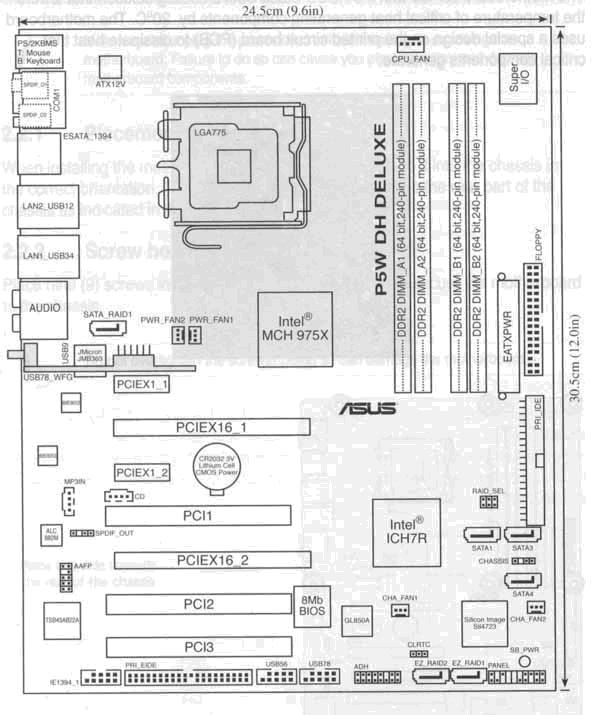

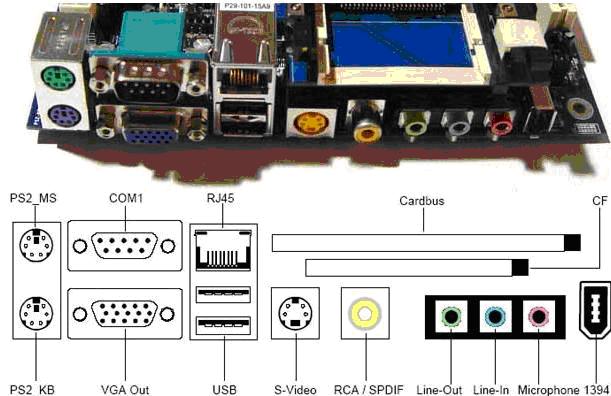

Distribución Placa Base

Fisicamente en la placa base los componentes se distribuyen de forma muy similar independientemente de la arquitectura de chipset que se emplee. A continuación se muestran dos ejemplos, el esquema e imagen de una placa base para procesador Pentium 4 y el esquema e imagen de una placa base para un procesador i7 de Intel.

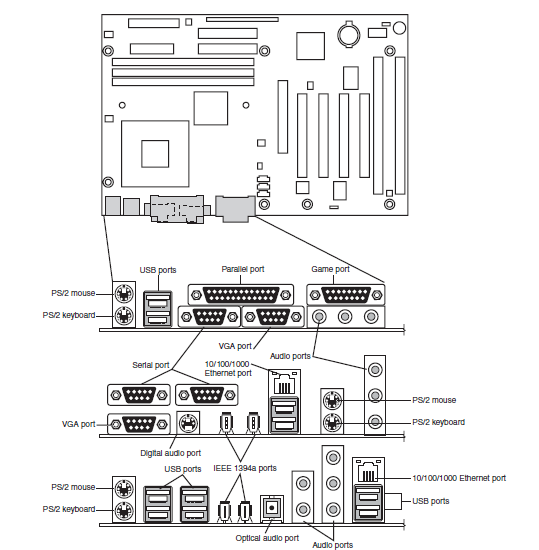

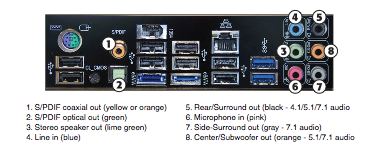

Y en cuanto a los puertos disponibles en la parte trasera de una placa base, puede variar en función de las características de la misma. A continuación se muestra algunos ejemplos más o menos actuales con los puertos más comunes.

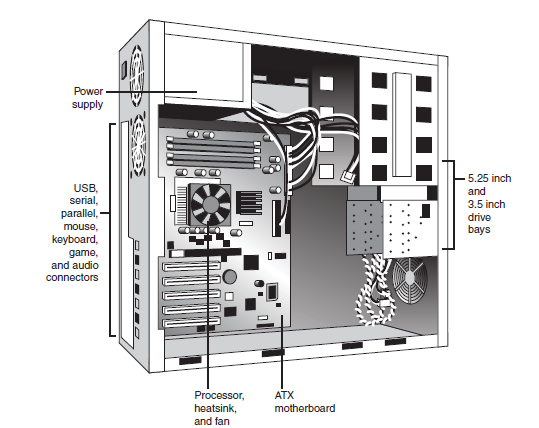

Y en lo que se refiere a la ubicación de la placa base en el chasis o caja del ordenador, en la siguiente imagen se muestra cual es la posición correcta.

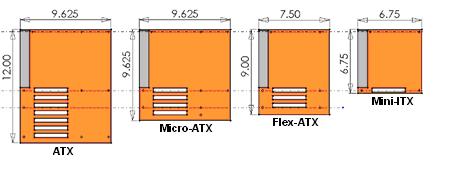

Formatos de Placa Base

El tamaño de las placas base debe ajustarse siempre al tamaño de la caja donde deben ir montadas. Es lo que se conoce como factor de forma de una placa base. Definen aspectos de la placa base como pueden ser la distribución de sus componentes o sus dimensiones físicas (como por ejemplo, el ancho y largo de ésta). Con el paso de los años se han ido imponiendo varios factores de forma. Estos son algunos de ellos:

- AT: Uno de los formatos más grandes. Muy utilizado hasta el año 1995

- ATX: Muy extendido y utilizado actualmente. Introduce por primera vez un panel de conexiones IO y define el tamaño para el conector de energía

- microATX: Es un estándar diseñado explícitamente para ser compatible con ATX pero con un tamaño menor

- FlexATX: Es un estándar basado en ATX que reduce aún más el tamaño con respecto a microATX

- ITX: Diseñado con el propósito de reducir el tamaño de la placa base y de incluir el mayor número de componentes en la misma. Propicia la aparición de microITX y sucesivos factores de forma (nanoITX, picoITX) que reducen todavía más el tamaño, favorecido por el creciente interés que hay en la actualidad por los ordenadores de pequeño tamaño

Los puertos más habituales que podemos encontrar en una placa base actual son los siguientes:

- Puerto teclado PS/2

- Puerto ratón PS/2

- Puertos USB 2.0

- Puertos USB 3.0

- Puerto paralelo

- Puerto serie

- Puerto de video analógico VGA

- Puerto de video digital DVI

- Puertos de audio: salida de audio, micrófono, salida de TV, . . .

- Puerto IEEE 1394 / FireWire

- Ethernet 10/100/1000

- Puerto eSATA (external SATA)

- Puerto Thunderbolt

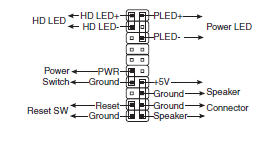

Conectores panel frontal

Normalmente las cajas de ordenador vienen con una serie de conectores para los interruptores (normalmente encendido/apagado y reset) y los leds (encendido y disco duro, normalmente) de la parte frontal de la misma. Además, en ocasiones vendrán acompañados de conectores para los puertos USB frontales de los que disponga, que deberán ser conectados a la placa base.

En el caso de los interruptores y leds de la caja, en la placa base disponemos de una serie de conectores como los de la figura, con una distribución específica, donde corresponderá cada uno de las conexiones de las que dispone la caja. Normalmente la configuración específica de dichos conectores deberá consultarse en el manual de la placa base, puesto que puede variar de alguna manera.

Para el caso de los puertos USB frontales, también se dispone de conectores suficientes en la placa base para su conexión al bus en la placa base.

Buses de comunicación

En una placa base podemos encontrar diferentes tipos de buses de comunicación en cuanto a la forma en que envían la información y en cuanto a la tecnología utilizada y propósito de los mismos.

Un bus es un canal de comunicación que sirve de interconexión entre dos o más componentes informáticos.

Actualmente un PC tiene una jerarquía de buses, compuesta de al menos 3 ó 4 buses. Se considerar jerarquía porque cada bús más lentos se encuentra conectado a un bus más rápido que él. Cada componente del equipo se encuentra conectado a un bus concreto y a su vez algunos componentes (chipset) pueden hacer de puente entre dos buses diferentes.

Los principales buses de un sistema informático son:

- Bus del procesador: También conocido como FSB, es el bus más rápido de todo el sistema y comunica al procesador con la placa base (concretamente con el puente norte o el controlador de memoria). Actualmente se le denomia QPI (Quick Path Interconnect) en procesadores Intel e HyperTransport en AMD

- Bus ISA: Bus ya desaparecido que surgió en los primeros PCs para conectar algunos periféricos

- Bus PCI: Bus que pasó a sustituir al bus ISA por su mayor velocidad, destinado a la conexión de tarjetas de expansión y otros componentes del sistema. Hasta el momento ha pasado por varias evoluciones: PCI-X y PCIe (PCI Express), que actualmente es la versión más rápida y que ha pasado a sustituirle

- Bus AGP: Bus que pasó a sustitutir al bus PCI pero solamente en el apartado de gráficos. Era un bus dedicado sólo a gráficos puesto que proporcionaba mayor velocidad que el PCI y además se conectaba directamente al puente norte del sistema. Hace ya tiempo que cayó en desuso en favor del PCI Express

- Bus PCI Express: Aparece en el año 2004 y pasa a ser el bus por defecto para todos los sistemas y componentes. Disponible en diferentes velocidades, el de mayor velocidad se emplea para la conexión de tarjetas gráficas

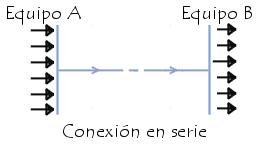

Tipos de buses: serie y paralelo

De una manera muy general, podemos diferenciar entre dos tipos de buses en función de cómo viajan los datos a través de ellos

Bus serie

Los puertos serie (también llamados RS-232, por el nombre del estándar al que hacen referencia) fueron las primeras interfaces que permitieron que los equipos intercambiaran información con algún periférico. El término serie se refiere a los datos enviados mediante un solo canal: los bits se envían uno detrás del otro, tal y como se indica en la figura:

Originalmente, los puertos serie sólo podían enviar datos, no recibir, por lo que se desarrollaron puertos bidireccionales (que son los que se encuentran en los equipos actuales). Por lo tanto, los puertos seriales bidireccionales necesitan dos canales para que la comunicación pueda efectuarse.

La comunicación serie se lleva a cabo asincrónicamente, es decir que no es necesaria una señal (o reloj) de sincronización: los datos pueden enviarse en intervalos aleatorios. A su vez, el periférico debe poder distinguir los caracteres (un carácter tiene 8 bits de longitud) entre la sucesión de bits que se está enviando.

Ésta es la razón por la cual en este tipo de transmisión, cada carácter se encuentra precedido por un bit de ARRANQUE y seguido por un bit de PARADA. Estos bits de control, necesarios para la transmisión serie, desperdician un 20% del ancho de banda (cada 10 bits enviados, 8 se utilizan para cifrar el carácter y 2 para la recepción).

Hay que tener en cuenta que actualmente la tendencia es a la implementación de buses serie de altas prestaciones. Muchas de las tecnologías que empleaban buses paralelos para comunicarse han pasado a desarrollar en los últimos años buses series para llevar a cabo dichas comunicaciones. En los buses paralelos uno de los principales problemas es el desfase de tiempo que pueda haber entre bits enviado al mismo tiempo (y que deben llegar al mismo tiempo). Desfase que se acentúa a medida que aumenta la longitud del cable. Eso hace díficil aumentar la velocidad de las comunicaciones, puesto que el desfase sería más díficil de controlar.

En ese sentido, un bus serie no presenta ese problema puesto que los bits son enviados uno detrás de otro por lo que la velocidad de reloj del bus se puede aumentar mucho más facilmente.

Además, los buses paralelos siempre han sido mucho más caros puesto que están compuestos de muchas más lineas de comunicación que los cables serie.

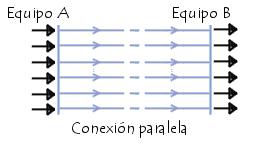

Bus paralelo

La transmisión de datos paralela consiste en enviar datos en forma simultánea por varios canales. Los puertos paralelos en los PC pueden utilizarse para enviar 8 bits (un octeto) simultáneamente por 8 hilos

Los primeros puertos paralelos bidireccionales permitían una velocidad de 2,4 Mbps. Sin embargo, los puertos paralelos mejorados han logrado alcanzar velocidades mayores:

- El EPP (puerto paralelo mejorado) alcanza velocidades de 8 a 16 Mbps

- El ECP (puerto de capacidad mejorada), desarrollado por Hewlett Packard y Microsoft. Posee las mismas características del EPP con el agregado de un dispositivo Plug and Play que permite que el equipo reconozca los periféricos conectados

Buses de expansión (Buses de entrada/salida)

Los buses de expansión son buses que poseen conectores que permiten agregar tarjetas de expansión (periféricos) a un equipo. Existen diferentes tipos de buses internos estándar que se caracterizan por:

- su forma

- el número de clavijas del conector

- los tipos de señales (frecuencia, datos, etc.)

- su velocidad

Bus ISA

La versión original del bus ISA (Industry Standard Architecture) que apareció en 1981 con PC XT fue un bus de 8 bits con una velocidad de reloj de 4,77 MHz.

Más adelante se expandió a un bus de 16 bits y la velocidad de reloj pasó de 6 a 8 MHz y finalmente a 8,33 MHz, ofreciendo una velocidad de transferencia máxima de 16 Mbps (en la práctica solamente 8 Mbps porque un ciclo de cada dos se utilizó para direccionar).

Hasta fines de la década de 1990, casi todos los equipos contaban con el bus ISA, pero fue progresivamente reemplazado por el bus PCI, que ofrecía un mejor rendimiento

Bus EISA

El bus EISA (Extended Industry Standard Architecture) fue desarrollado en 1988 para competir con el bus exclusivo MCA lanzado por IBM el año anterior. El bus EISA utilizaba conectores cuyo tamaño era la mitad del conector ISA pero con 4 filas de contactos en lugar de 2, para direccionar 32 bits.

Bus VLB

En 1992, el bus VLB (Vesa Local Bus) fue desarrollado por VESA (Asociación para estándares electrónicos y de video patrocinado por la compañía NEC) para ofrecer un bus local dedicado a sistemas gráficos. El VLB es un conector ISA de 16 bits con un conector de 16 bits agregado

El bus VLB es un bus de 32 bits inicialmente diseñado para permitir un ancho de banda de 33 MHz (el ancho de banda del primer PC 486). El bus local VESA se utilizó en modelos 486 así como en los primeros procesadores Pentium, pero fue reemplazado rapidamente por el bus PCI

Bus PCI

El bus PCI (Peripheral Component Interconnect) fue desarrollado por Intel en 1992. A diferencia del bus VLB, no se trata de un bus local tradicional sino de un bus intermedio ubicado entre el bus de procesador (Puente Norte) y el bus de entrada/salida (Puente Sur).

Por lo general, las placas madre contaban con al menos 3 ó 4 conectores PCI, identificables generalmente por su color blanco.

La interfaz PCI existe en 32 bits con un conector de 124 clavijas o en 64 bits con un conector de 188 clavijas.

Existen 2 tipos de conectores de 32 bits:

En general, no se pueden cometer errores al introducir una tarjeta PCI en una ranura PCI. Si la tarjeta encaja correctamente, entonces es compatible.

La versión original del bus PCI es de 32 bits de ancho y su velocidad de reloj es de 33 MHz, lo que en teoría permite un rendimiento de 132 Mbps a 32 bits. La versión más rápida del bus PCI trabajaba con 64 bits a una velocidad de 66 MHz, consiguiendo un rendimiento de 533 Mbps.

Con el fin de actualizar el estándar PCI, se formó un grupo de interés compuesto por un gran número de fabricantes.

El 1 de junio de 1995, la revisión 2.1 del bus PCI mejoró su uso hasta 66 MHz. En ese momento, los ingenieros anticiparon un movimiento progresivo desde un voltaje señalizado de 5 V hasta 3,3 V.

La versión 2.2 del bus PCI, que apareció el 18 de diciembre de 1998, incorporó la capacidad de conectar los periféricos directamente (conexión en caliente).

En septiembre de 1999, tuvo lugar un cambio importante en el bus PCI, cambio que fue conocido como PCI-X. El bus PCI-X 1.0 admite frecuencias de 66, 100 y 133 MHz. Dicho bus es completamente compatible con el formato PCI, y las ranuras PCI-X admiten tarjetas de formato PCI y viceversa.

La revisión 2.0 del bus PCI-X admite frecuencias efectivas de 66, 100, 133, 266 y 533 MHz (133 MHz a 4 datos por ciclo), y permite un rendimiento de 4,27 GBps con una ancho de bus de 64 bits.

Bus AGP

El bus AGP (Accelerated Graphics Port) apareció por primera vez en 1997 con el objetivo de administrar los flujos de datos gráficos que se habían vuelto demasiado grandes como para ser controlados por el Bus PCI. De esta manera, el bus AGP se conecta directamente al FSB (Front Side Bus) del procesador y utiliza la misma frecuencia, es decir, un ancho de banda más elevado.

La interfaz AGP se creó con el único propósito de conectarle una tarjeta de video. Funciona al seleccionar en la tarjeta gráfica un canal de acceso directo a la memoria (DMA, Direct Memory Access), evitado así el uso del controlador de entradas/salidas.

El puerto AGP 1X funciona a una frecuencia de 66 MHz, a diferencia de los 33 MHZ del Bus PCI, lo que le provee una tasa máxima de transferencia de 264 MBps (en contraposición a los 132 MBps que comparten las diferentes tarjetas para el bus PCI). Esto le proporciona al bus AGP un mejor rendimiento, en especial cuando se muestran gráficos en 3D de alta complejidad.

Los sucesivos modos AGP 2X, 4X y 8X duplican la velocidad de su antecesor llegando hasta los 2 GBps del último, que apareció a finales del año 2000.

Se debe tener en cuenta que las diferentes normas AGP son compatibles con la versión anterior, lo que significa que las tarjetas AGP 4X ó AGP 2X pueden insertarse en una ranura para AGP 8X.

Existen tres tipos de conectores:

Bus PCI Express

El bus PCI Express (también conocido como PCIe) es un bus de interconexión que permite añadir placas de expansión a un ordenador. El bus PCI Express fue desarrollado en 2002. A diferencia del bus PCI, que se ejecuta en una interfaz paralela, el bus PCI Express de desarrolló como un bus serie, lo que permite conseguir velocidades mucho mayores.

El bus PCI Express se presenta en diversas versiones (1X, 2X, 4X, 8X, 16X, 32X, según el número de canales simultáneos con los que se comunica), con rendimientos de entre 250 MBps (PCIe 1.1) y 1 GBps (PCIe 3.0) por canal (32 GBps en PCIe 3.0 32X). Actualmente este puerto ha reemplazado totalmente a los puertos AGP y se espera que vaya reemplazando al bus PCI en sus anteriores versiones.

Los conectores PCI Express no son compatibles con los conectores PCI más antiguos. Varían en tamaño. Una de las características más interesantes del bus PCI Express es que admite la conexión en caliente, es decir, que puede conectarse y desconectarse sin que sea necesario apagar o reiniciar la máquina. Los conectores PCI Express son identificables gracias a su tamaño pequeño y su color gris oscuro, aunque pueden presentar otros colores.

Además, actualmente se empieza a extender el uso de este Bus para la conexión de discos duros SSD (a través del interfaz M.2), por proporcionar mucho más ancho de banda que el bus SATA (destinado a unidades de almacenamiento).

El conector PCI Express 1X está destinado a usos de entrada/salida con un gran ancho de banda:

El conector PCI Express 4X está destinado a servidores:

El conector PCI Express 8X está destinado a servidores:

El conector PCI Express 16X está destinado a usarse como puerto gráfico:

Hay que tener en cuenta que, hoy en día, todavía es raro utilizar los puertos PCI Express 32X

Bus USB

El USB (Universal Serie Bus) es un bus estándar diseñado para proporcionar capacidad PnP (Plug aNd Play) para conectar dispositivos externos a un equipo informático. Otro de sus propósitos es el de servir de bus único para diferentes tipos de dispositivos.

En 1995, el estándar USB se desarrolló para la conexión de una amplia gama de dispositivos.

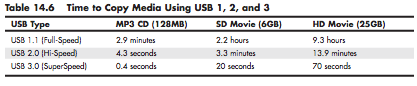

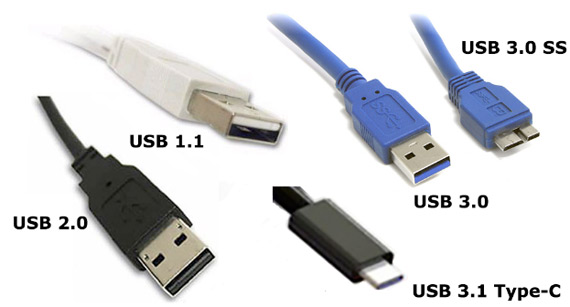

La versión inicial de USB (USB 1.1) ofrece una velocidad de 12 Mbps. Para dispositivos de baja velocidad, como teclados y ratones, ofrece un canal más lento a 1.5 Mbps.

El estándar USB 2.0, también conocido como Hi-Speed USB, permite alcanzar velocidades de hasta 480 Mbps (unas 40 veces más rápido que USB 1).

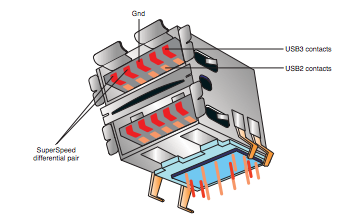

En el año 2008 aparece el estándar USB 3.0 (SuperSpeed USB), que proporciona una velocidad máxima de 5 Gbps, (lo que podría traducirse en una tasa de transferencia efectiva de 360 MBps), unas 10 veces más rápido que la versión anterior. Conviene considerar que esta velocidad es mucho mayor que la velocidad del disco duro magnético más rápido, por lo que un SSD conectado a un bus SATA (a 6 Gbps) es capaz de conseguir e incluso superar las cifras del bus USB 3.0.

Desde el año 2013 se trabaja en una versión de USB 3, USB 3.1 que permite una velocidad teórica de 10 Gbps.

Y desarrollado al mismo tiempo que el USB 3.1, aparece la especificación USB Type-C con el objetivo de desarrollar un conector reversible para conectar dispositivos USB. Elimina varios conectores tipo A y tipo B puesto que se utiliza a ambos lados (equipo y dispositivo).

Hay que tener en cuenta que todas las versiones de USB son totalmente compatibles con su versión anterior. El modo de trabajo de USB 2.0 es compatible con USB 1.1 y la última versión, USB 3.0, incluye los conectores USB 2.0/1.1 para ser compatible con el modo de trabajo de las versiones anteriores.

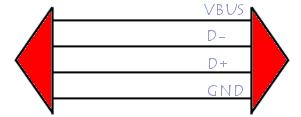

Una característica de la arquitectura USB es que puede proporcionar fuente de alimentación a los dispositivos con los que se conecta, con un límite máximo de 15 V por dispositivo. Para poder hacerlo, utiliza un cable que consta de cuatro hilos (la conexión a tierra GND, la alimentación del BUS y dos hilos de datos llamados D- y D+).

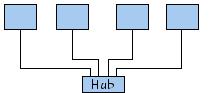

La comunicación entre el host (equipo) y los dispositivos se lleva a cabo según un protocolo (lenguaje de comunicación) basado en el principio de red en anillo. Esto significa que el ancho de banda se comparte temporalmente entre todos los dispositivos conectados. El host (equipo) emite una señal para comenzar la secuencia cada un milisegundo (ms), el intervalo de tiempo durante el cual le ofrecerá simultáneamente a cada dispositivo la oportunidad de hablar.

Los puertos USB admiten dispositivos PnP de conexión en caliente. Por lo tanto, los dispositivos pueden conectarse sin apagar el equipo (conexión en caliente). Cuando un dispositivo está conectado al host, detecta cuando se está agregando un nuevo elemento gracias a un cambio de tensión entre los hilos D+ y D-. En ese momento, el equipo envía una señal de inicialización al dispositivo durante 10 ms para después suministrarle la corriente eléctrica mediante los hilos GND y VBUS (hasta 100 mA). A continuación, se le suministra corriente eléctrica al dispositivo y temporalmente se apodera de la dirección predeterminada (dirección 0). La siguiente etapa consiste en brindarle la dirección definitiva (éste es el procedimiento de lista). Para hacerlo, el equipo interroga a los dispositivos ya conectados para poder conocer sus direcciones y asigna una nueva, que lo identifica por retorno. Una vez que cuenta con todos los requisitos necesarios, el host puede cargar el driver adecuado.

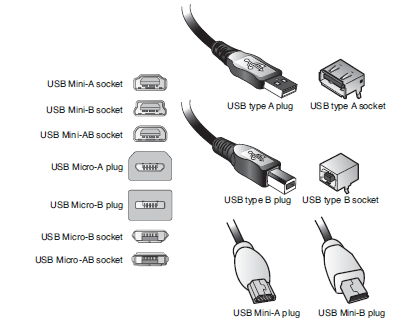

Sobre los diferentes conectores USB que existen en la actualidad, podemos destacar 4 principales series: Serie A, Serie B, Mini-A y Mini-B.

- Serie A: Diseñados para la conexión entre un dispositivo (un ratón o teclado, por ejemplo) y un equipo o hub

- Serie B: Diseñados para la conexión del lado de un dispositivo del que se puede desconectar el cable (una impresora, por ejemplo)

- Mini-A y Mini-B: Son simplemente versiones más pequeñas de los dos anteriores, respectivamente

Adaptadores USB

Con la finalidad de reutilizar los viejos periféricos sacando partido de las conexiones USB de las nuevas placas base, han ido apareciendo numerosos conversores o adaptadores.

- USB a paralelo

- USB a serie

- USB a Ethernet

- USB a Wireless Ethernet

- USB a PS/2

- USB a Audio

- USB a TV

Bus IEEE 1394

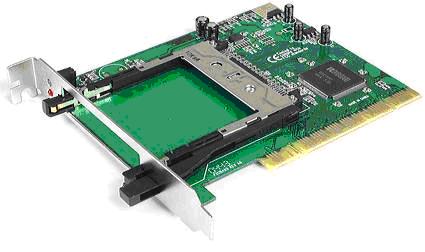

El bus IEEE 1394 (nombre del estándar al cual hace referencia) fue desarrollado en 1995 con el objetivo de brindar un sistema de intercomunicación que permita transferir datos a alta. La compañía Apple le dio el nombre comercial FireWire, y como se lo conoce comúnmente. Se trata de un puerto existente en algunos equipos que permite conectarse a distintos periféricos (en particular cámaras digitales) con un ancho de banda alto. Existen tarjetas de expansión (generalmente en formato PCI o PC Card / PCMCIA) que le permiten equipar un ordenador con conectores FireWire.

Existen diversos tipos de conectores FireWire para cada uno de los estándares IEEE 1394.

Actualmente, el estándar IEEE 1394c proporciona velocidades de hasta 3,2 Gbps. Es lo que comercialmente se conoce como FireWire s800T.

Hay que tener en cuenta que actualmente USB es el interfaz más utilizado en los equipos informáticos para la interconexión de periféricos. Intel lo ha popularizado incluyendolo en sus chipset desde su aparición. Además, el uso del interfaz IEEE 1394 tiene un sobrecoste en concepto de \emph{royalties} a Apple, lo que no favorece la popularidad del mismo.

A pesar de todo eso, el bus IEEE 1394 sigue teniendo su cuota de mercado gracias a una característica que USB no tiene. El bus IEEE 1394 es capaz de interconectar dos dispositivos sin la necesidad de que haya un PC de por medio, cosa que USB no puede. Siempre que queramos conectar dos dispositivos entre sí por USB necesitaremos un PC al que conectar los dispositivos de manera que sea éste quien gestione la transferencia de información. Con el bus 1394 es posible conectar, por ejemplo, una cámara de video digital a un reproductor de video directamente para reproducir o editar. Además, para el caso de conectar un dispositivo a un PC, la potencia del PC utilizado afecta en gran medida a la velocidad de transferencia, mientras que el bus 1394 es mucho más independiente del equipo utilizado, afectándole en menor medida una reducción en las prestaciones del equipo que se utilice para interconectar los dispositivos.

Bus Thunderbolt

En el año 2009 Intel y Apple presentan un nuevo bus, Thunderbolt, basado en tecnología óptica capaz de alcanzar una velocidad de 10 Gbps en su versión actual. Además, es capaz de utilizar múltiples protocolos, por lo que se podrá utilizar para la comunicación de audio y video como para datos. En el año 2011 comienza a utilizarse, sobre todo para la interconexión de discos duros SSD externos por parte de Intel y en la interconexión de diferentes dispositivos por parte de Apple.

Hacia el año 2013 aparece la segunda versión de este estándar (Thunderbolt 2) doblando la velocidad de la primera versión, llegando a los 20 Gbps. Actualmente se trabaja en Thunderbolt 3, para el que se anuncia una velocidad de 40 Gbps (5 GBps). Además, utilizará el nuevo conector USB Type-C y vendrá con soporte para PCIe 3.0, HDMI y DisplayPort. Al igual que hace el bus USB, proporcionará suficiente alimentación (100 w) para eliminar los cables de alimentación en muchos de los dispositivos soportados.

Bus PCMCIA

En 1989, el consorcio PCMCIA (Personal Computer Memory Card International Association) desarrolló el bus PC Card, (conocido como PCMCIA también), con el fin de extender a los ordenadores portátiles la conectividad de los equipos periféricos disponibles

Bus CardBus

El estándar CardBus (a veces denominado PC Card de 32-bits) apareció en el año 1995, permitiendo la transferencia de datos a 32 bits a una velocidad de 33 MHz, con una carga de 3V (en contraste con los 5,5 de PCMCIA).

Memoria

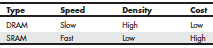

Aunque en el bloque 1 de la asignatura vimos como tratábamos como memoria a todo elemento que era capaz de almacenar información, a la hora de hablar de dispositivos la clasificación será otra puesto que los diferentes tipos de memoria se representan por dispositivos totalmente diferentes. Así, en este apartado cuando hablamos de memoria nos referimos a la memoria principal, comúnmente conocida como memoria o memoria RAM (Random Access Memory, Memoria de Acceso Aleatorio). La tecnología de acceso aleatorio permite que el sistema pueda obtener cualquier dato de la memoria sin tener que pasar por todos los anteriores, al contrario que ocurre con las memorias de acceso secuencial (como las cintas o en cierta medida los discos duros, que deben esperar a que el dato pase por la cabeza lectora).

La memoria RAM es un tipo de memoria conocida como DRAM (Dynamic RAM), que difiere de la que se conoce como SRAM (Static RAM), que es la memoria utilizada para fabricar, por ejemplo, las memorias caché de los procesadores. La diferencia principal entre ambas es que la primera necesita que los datos sean refrescados para cierto tiempo (período de refresco) para que se mantengan, lo que hace que este tipo de memorias sean más lentas. Por otro lado, las memorias DRAM tienen una mayor densidad, y por ello es posible almacenar más cantidad de información en un menor espacio, siendo además más barata de fabricar que la SRAM. Además, la memoria DRAM es mucho más barata que la SRAM. Hay que tener en cuenta que las memorias SRAM consiguen velocidades similares a las del procesador, mientras que las memorias DRAM están muy por debajo. Es por ello que las memorias caché de los procesadores se utilizan como buffers de los datos más utilizados por la memoria RAM.

Desde el punto de vista de un dispositivo hardware, la memoria RAM se adquiere por módulos, que podrán ser de diferentes capacidades (1 GB, 2 GB, . . .) y que se conectan directamente a la placa base del ordenador en los zócalos o bancos de memoria. Dependiendo de la propia placa, podrán aparecer (actualmente) entre 2 y 6 bancos de memoria donde se podrá conectar cualquier combinación de módulos con iguales o diferentes capacidades. En este caso, para mejorar el rendimiento, habrá que valorar si se dispone de tecnología de doble o triple canal en la placa base, de forma que una determinada ubicación de los módulos de memoria puede repercutir en un mayor rendimiento (ver anexo).

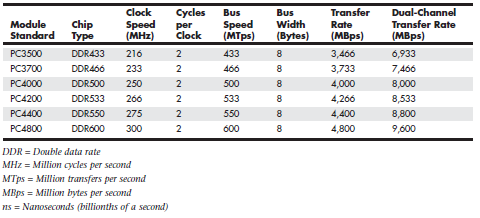

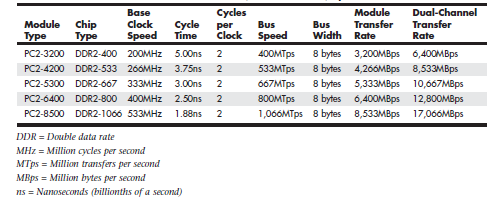

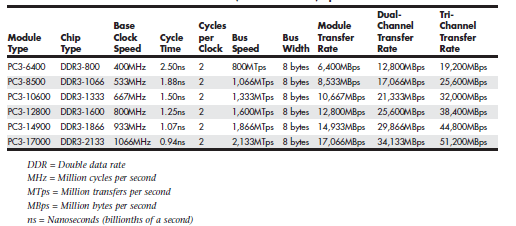

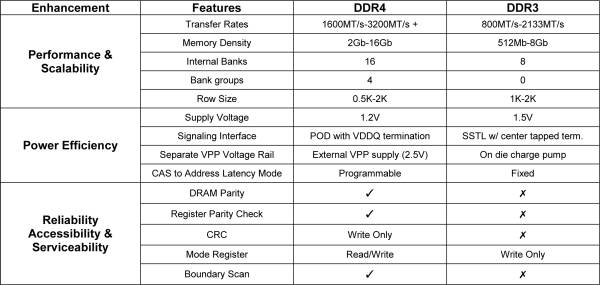

Otros parámetros a tener en cuenta serán la tecnología utilizada para la fabricación del módulo (Hoy en día podríamos decir que coexisten hasta 3 tecnologías diferentes de memorias RAM: DDR SDRAM, DDR2 SDRAM y DDR3 SDRAM; conocidas por el primer acrónimo cada tecnología, incompatibles entre si, aunque algunas placas pueden soportar más de un tipo pero no al mismo tiempo), la velocidad de acceso a la misma, que podrá variar incluso en módulos fabricados con la misma tecnología, tecnologías como el acceso de doble o triple canal y la conexión de los bancos de memoria directamente con el procesador como se viene haciendo en las arquitectura más modernas.

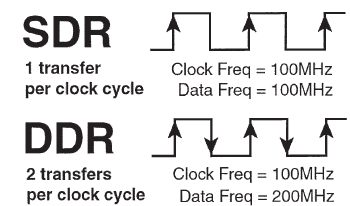

Otra medida interesante a la hora de adquirir memoria RAM es su velocidad de reloj, que podemos distinguir entre velocidad física y velocidad efectiva. La velocidad de la memoria nos indica los ciclos de reloj y la velocidad efectiva nos proporciona el rendimiento global de la misma teniendo en cuenta su velocidad de reloj y el aprovechamiento que ésta hace en cada ciclo. En el caso de la memoria DDR (Double Data Rate), con respecto a la anterior tecnología, la memoria SDR (Simple Data Rate), se hace un doble aprovechamiento de cada ciclo, por lo que la velocidad efectiva duplica a la velocidad real. DDR basa su tecnología en el mayor aprovechamiento de cada ciclo, por lo que la velocidad física y efectiva nunca coincidirá (como ocurría con tecnologías anteriores). Es por eso que normalmente nos darán y nos interesará conocer la velocidad efectiva, puesto que nos permite comparar el rendimiento real de una memoria con otra de diferente tecnología. Aunque hay que tener en cuenta que también es bastante común hoy día proporciona la medida del ancho de banda, expresado en MBps y que resulta muy útil para comparar.

Conviene tener en cuenta que hoy en día también podemos encontrar la denominación DDR3L (low voltage) ó DDR3U (ultra low) para hacer referencia a módulos de memoria que son capaces de trabajar a más baja frencuencia que los demás de la misma tecnología.

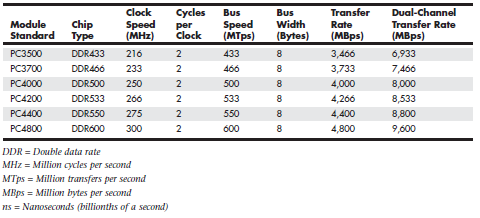

Evolución memoria DDR

A continuación se muestra la evolución de las diferentes tecnologías de memoria DDR hasta la actualidad.

La memoria RAM es, actualmente, uno de los datos que más se tienen en cuenta a la hora de adquirir un nuevo sistema, hasta llegar al punto de adquirir sistemas sobredimensionados en cuanto a memoria se refiere, bien por el bajo precio de la misma o bien por desconocimiento en cuanto al cálculo de cuanta memoria necesita un ordenador para el propósito al que se va a destinar.

Como ya se vió, la memoria RAM se utiliza para almacenar en ella cualquier programa que se encuentra en ejecución. Así, lo recomendable es adquirir tanta memoria como cantidad de programas considere que necesitaré ejecutar al mismo tiempo, con el fin de optimizar el uso de mi equipo. Por otro lado, hay que tener en cuenta que toda la cantidad de memoria que yo no sea capaz de “llenar” con programas en ejecución no ayuda de manera alguna a mejorar el rendimiento de todo el conjunto. Es por ello que puede darse el caso de equipos que en toda su vida útil jamás hagan uso de toda la memoria de la que disponen y por tanto se haya tomado una mala decisión a la hora de adquirirlo para el cometido al que se había destinado.

Es importante tener en cuenta también el momento en el que se adquiere la memoria. Su precio es muy cambiante por lo que dependiendo de la época o necesidades presentes conviene comprar la estrictamente necesaria, y si más adelante fuera necesario siempre podrá ampliarse adquiriendo algún módulo adicional.

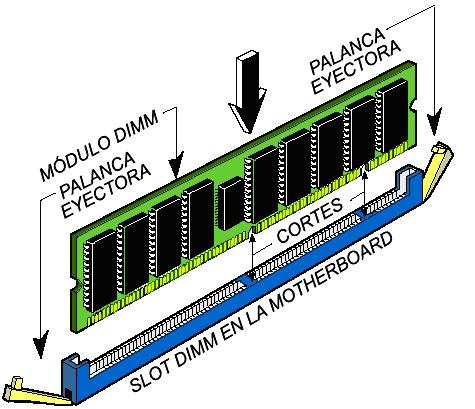

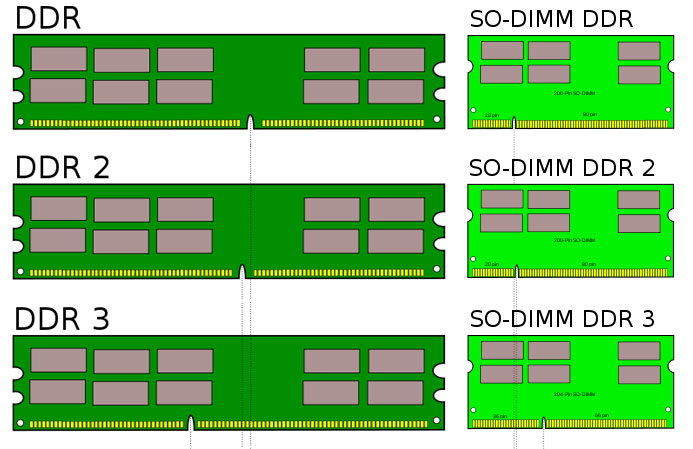

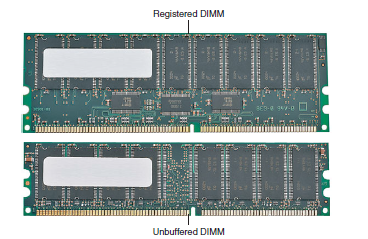

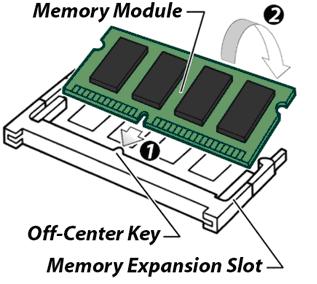

Cuándo hablamos de módulos de memoria RAM, hablamos de los componentes que se conectan al ordenador. Estos componentes tienen soldados los chips de memoria (de una tecnología concreta). Así, en el caso de memorias DDR, DDR2 y DDR3 se utilizan módulos DIMM (aunque incompatibles entre ellos, como puede verse en la figura). En el caso de ordenadores portátiles los módulos de memoria son de tipo SO-DIMM, al tratarse de módulos de memoria de tamaño más reducido. A pesar del reducido tamaño estos módulos utilizan la misma tecnología y capacidades que los dedicados a equipos de sobremesa.

En el momento del montaje, los módulos DIMM de diferentes tecnologías se diferencian entre ellos por una marca que determina la forma correcta a la hora de conectarla en la placa base.

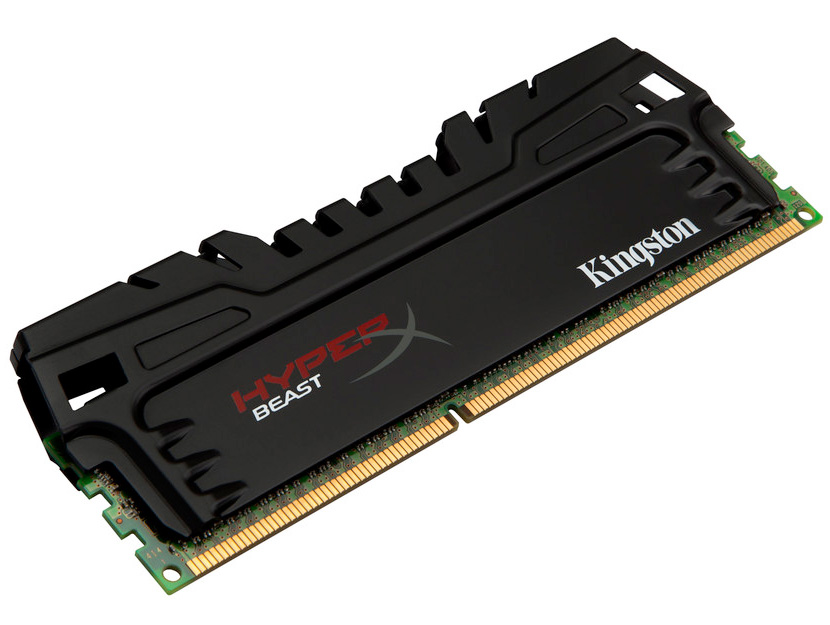

En ocasiones, también podremos encontrarnos módulos de memoria de alto rendimiento recubiertos por un disipador que les ayuda a eliminar el calor que generan.

Módulos registrados

Cabe destacar también los módulos de memoria conocidos como Registered. Estos módulos incluyen chips adicionales para conseguir más estabilidad y permiten gestionar mayores cantidades de memoria conectando un mayor número de módulos sin que haya perturbaciones en las señales del controlador de memoria. Este tipo de memorias se utiliza en ordenadores destinados a servidor y no son compatibles con cualquier controlador de memoria.

Compatibilidad

Para garantizar el correcto funcionamiento de los módulos de memoria de todos los fabricantes, la asociación JEDEC define un estándar para la especificación de los chips y módulos. A pesar de eso, entre diferentes módulos puede haber variación de velocidad, voltaje y otras características que hacen que no cualquier módulo funcione en cualquier equipo, por lo que hay que tener especial cuidado a la hora de adquirirlos asegurándonos de que funcionará correctamente en nuestro sistema.

En general hay que tener en cuenta que no es posible mezclar módulos de diferentes tecnologías (SDRAM, DDR, DDR2 ó DDR3). Aunque algunas placas base incluyen slots para dos tecnologías diferentes, no es posible mezclarlas sino que sólo puedan conectar módulos de una sola tecnología al mismo tiempo.

Paridad y ECC

Puesto que de manera inevitable los módulos de memoria RAM pueden fallar, existen técnicas para la detección y corrección de errores en la transmisión de información.

Los sistemas basados en el bit de Paridad permiten detectar errores de memoria pero no son capaces de corregirlos mientras que la técnica ECC (Error-Correcting Code) es capaz de detecetar y corregir algunos errores.

No todas los módulos de memoria incorporan la tecnología ECC debido al sobrecoste que supone y porque el resto del sistema debe ser compatible esa tecnología (procesador, placa base y la propia memoria). Además, hay que tener en cuenta que la técnica de chequeo de errores hace que su rendimiento se vea mermado (aunque muy poco) puesto que tiene que hacer comprobaciones adicionales que las memorias sin esta tecnología no tienen que hacer. Por ello, las memorias ECC se suelen utilizar en sistemas que necesitan de un alto grado de tolerancia a fallos, donde un fallo en la memoria puede sobrecargar el sistema para corregirlo.

Latencia

Existen varios tipos de latencia (CAS, RAS, ACTIVE y PRECHARGE). Cada uno de ellos mide el tiempo que le cuesta a la memoria realizar una operación determinada, normalmente en cuanto al acceso a un dato o a su ubicación se refiere.

Por ejemplo, la latencia CAS (o latencia CL) indica el tiempo que tarda la columna de un dato en ser localizada desde que éste es solicitado, concretamente expresa los ciclos de lantecia de un módulo de memoria determinada de forma que una cifra más baja indica mayores velocidades (un módulo con latencia CL2 será más rapido que uno con CL4).

Actualmente en muchos casos nos lo indicarán mediante un grupo de números que indican estos tiempos de acceso. Debemos que tener en cuenta que al tratarse de tiempos de acceso, cuanto menores sean dichos valores, más rápida será la memoria. Conviene también tener en cuenta que, por lo general, estos valores serán más alto cuanto mayor sea la frecuencia de la memoria, puesto que a velocidades mayores, más díficil es controlar la latencia. En cualquier caso, la cifra de latencia sólo debería utilizarse para medir módulos de igual frecuencia.

Es posible mezclar módulos con diferentes valores de latencia en un mismo sistema pero normalmente la latencia de toda la memoria será la de aquella que tenga la mayor latencia.

Identificar un módulo de memoria

La mayoría de módulos de RAM vienen etiquetados de forma que sea posible identificar todas las características del mismo de forma rápida. Por el aspecto físico y la muesca del módulo podemos determinar si se trata de un módulo DIMM y de que tecnología (DDR, DDR2 ó DDR3), pero hay muchos otros parámetros que necesitamos conocer para saber con exactitud las características de ese módulo.

Supongamos un módulo de memoria RAM de la marca Kingston, concretamente de la serie ValueRam, que contiene la siguiente etiqueta: KVR533D2N4K2/512 .

- KVR: Fabricante y modelo, Kingston ValueRam

- 533: Velocidad, 533 MHz

- D2: Tecnología, DDR2

- N: Non ECC

- 4: Latencia CAS

- K2: Kit 2 módulos

- 512: Capacidad, en MB en este caso (cuando se trata de GB aparece la letra G a la derecha de la cantidad)

También podemos encontrar otras denominaciones como las siguientes a la hora de tener que identificar un módulo de memoria:

En esta guía la compañia que desarrolla los módulos de memoria Kingston explica los códigos utilizados en su módulos de memoria de la serie HyperX (dedicadas a alto rendimiento).

Y en esta otra guía explican los códigos utilizados en los módulos ValueRam.

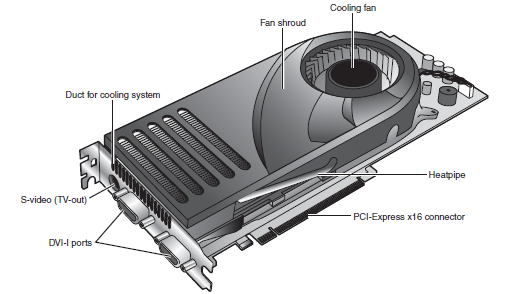

Hardware de video

En un equipo informático, el sistema de video lo forman la tarjeta gráfica y el monitor. La tarjeta gráfica es el componente que conecta la placa base con el monitor y se encarga de procesar toda la información que se muestra por éste.

La tarjeta es uno de los componentes que más importancia ha ganado en los últimos años. Ha evolucionado mucho, hasta convertirse en un elemento de mucho peso a la hora de adquirir un equipo informático. Hoy en día se evalúan casi las mismas características a la hora de adquirir una tarjeta gráfica y una CPU.

No es posible concebir un equipo sin tarjeta gráfica (excepto en servidores) pero en los últimos años es uno de los componentes más importantes a la hora de adquirir uno. Ha crecido su potencia de procesamiento, su memoria dedicada (y la tecnología de ésta, siempre a la última) de tal forma que casi se asemeja a la de algunos procesadores no tan anteriores en el tiempo

Tipos de tarjetas gráficas

- Tarjeta gráfica dedicada: La tarjeta gráfica se conecta al sistema a través de una ranura de expansión (actualmente PCI-Express) de forma que puede proporcionar los mayores niveles en cuanto a características y rendimiento

- Tarjeta gráfica integrada en la placa base: La tarjeta gráfica se encuentra integrada en la placa base como parte del chipset y el sistema comparte la memoria RAM y algunos otros componentes con la misma. El rendimiento siempre será menor por lo que es una solución muy utilizada para equipos portátiles o equipos de escritorio de bajo coste

- Tarjeta gráfica dedicada integrada en la placa base: Una tarjeta gráfica dedicada se encuentra integrada en la placa base. Es la solución actual para equipos portátiles que necesitan un buen rendimiento gráfico

- Tarjeta gráfica integrada en el procesador: La tarjeta gráfica se encuentra integrada dentro del procesador. Es la solución hardware más barata y el rendimiento es menor por lo que se utiliza con el principal motivo de ahorrar energía en portátiles y en dispositivos móviles, aunque actualmente los últimos modelos de Intel y AMD integran un procesador gráfico junto con el procesador (modelos serie i de Intel y Fusion de AMD)

Componentes

Entre los componentes que forman una tarjeta gráfica destacan los siguientes:

- GPU (Graphical Processor Unit): Es un procesador dedicado a gráficos. El objetivo de la GPU es liberar al procesador de carga de trabajo en todo el apartado gráfico. Entre sus componentes destacan los Shaders que es la parte de la GPU encargada de reproducir diferentes efectos y trabajar con la luz (realismo, sombras, explosiones, . . .). Actualmente el mercado de GPUs se reparte casi en su totalidad entre ATi (ahora AMD) y nVIDIA. Aunque hay otros fabricantes minoritarios como Matrox ó S3 Graphics.

- Memoria: Almacenan la información que debe procesar la tarjeta gráfica. No determinan el mayor o menor rendimiento de ésta pero una cantidad muy baja puede limitarlo. Su capacidad determina la cantidad de datos y texturas procesadas y actualmente se utiliza como estragegia de marketing para hacer creer al consumidor que a mayor cantidad de memoria, mayor rendimiento. Además, hay que tener en cuenta que podemos encontrarnos con dos tipos de memoria: dedicada, cuando la tarjeta gráfica dispone de esa cantidad de memoria de forma independiente y compartida, cuando se utiliza parte de la memoria RAM del ordenador por la tarjeta gráfica. Normalmente la memoria RAM es más lenta que la incopora de manera dedicada una tarjeta gráfica por lo que es preferible disponer de memoria dedicada para aumentar el rendimiento de la tarjeta

- RAMDAC: Realiza la conversión de la señal digital de la tarjeta gráfica a señal analógica para el monitor. Debido a la creciendo popularidad de los monitores de entrada digital, este componente está cayendo en desuso.

- Salidas: Como se comenta más adelante en este apartado, actualmente se están empleando 3 salidas de video diferentes, aunque no siempre están todas presentes en una tarjeta gráfica. Se explican más abajo.

- Alimentación: Actualmente un problema debido al creciente consumo de energia de las tarjeta gráficas más actuales. Debido a que el puerto PCIe sólo es capaz de proporcionar 75W, algunas tarjetas gráficas necesitan un aporte adicional de energía directamente desde la fuente de alimentación. En esos casos es necesario disponer de una fuente de alimentación potente (a partir de 500W) que disponga de PCIe power conector para alimentar directamente la tarjeta

- Bus de conexión: Conecta la tarjeta gráfica con la placa base. Actualmente se utiliza PCI-Express

- Drivers: Es el software que comunica a la tarjeta gráfica con el Sistema Operativo

A medida que han ido evolucionando sus prestaciones, también se ha modificado la forma en la que se conectan a la placa base. Cuanto más rendimiento obtenían mejor conexión con la placa necesitaban, lo que se conoce como el bus: VESA, PCI, AGP, PCI-X y PCI-E; siguiendo un orden cronológico.

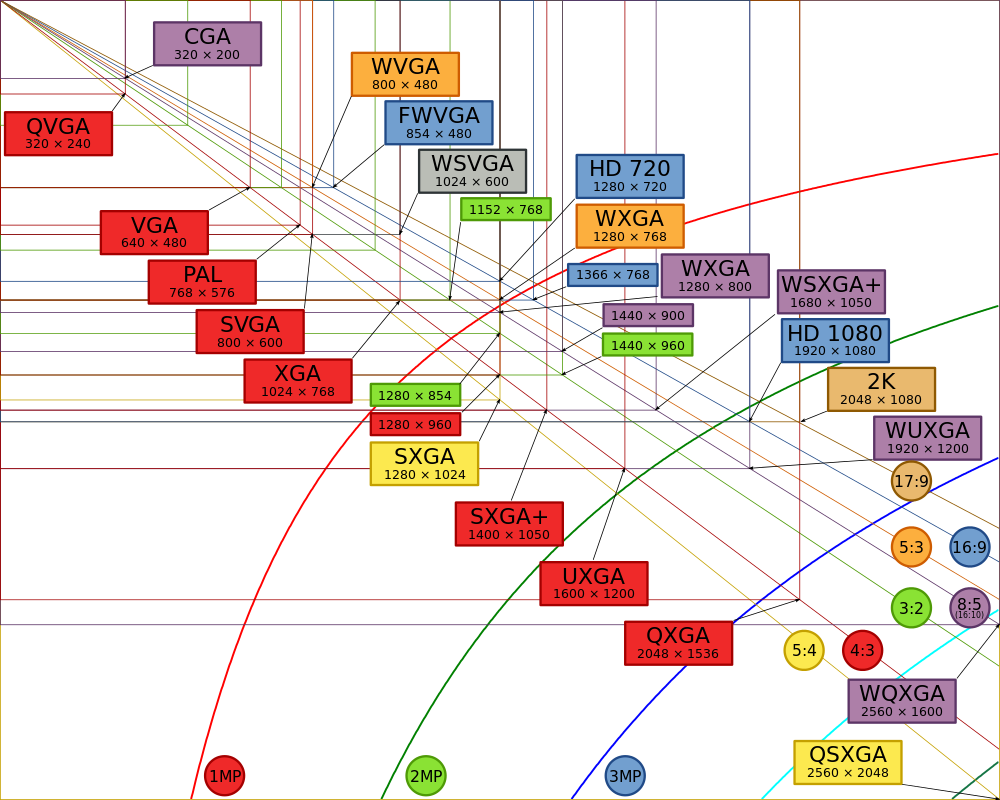

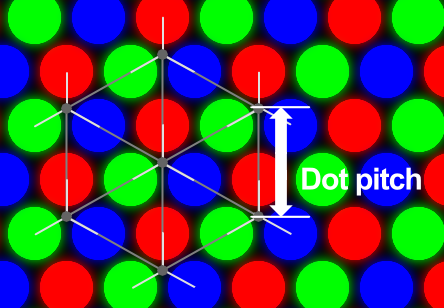

Por otro lado, ha mejorado la calidad de los gráficos mostrados por pantalla, por lo que se ha mejorado la conexión de la tarjeta gráfica con el monitor, que a su vez también ha mejorado en tecnología (CRT, DSTN, TFT), resolución (número de píxeles, CGA, EGA, VGA, XGA, WXGA, . . ), tamaño de punto (dot pitch) y contraste.

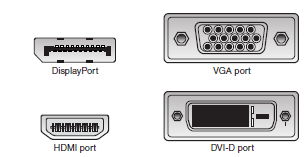

- VGA: Salida de video analógica utilizada durante muchos años y aún muy extendida en la actualidad

- DVI: Salida de video digital que salió para sustituir a VGA.

- HDMI: Salida de video digital que incorpora audio en la misma conexión. Actualmente se está implantando con mucha rapidez en equipos informáticos, sistemas multimedia y televisores. También disponible en versión mini para dispositivos de pequeño tamaño como tablets

- DisplayPort: Salida de video digital (con posibilidad de transmitir también audio), competidor directo de HDMI, también disponible en versión mini para dispositivos de pequeño tamaño

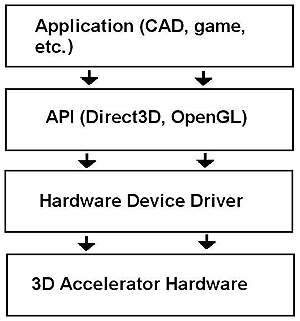

APIs

Las API (Application Programming Interface) proporcionan a los fabricantes de hardware y software la manera de crear drivers y programas que puedan trabajar facilmente con una gran variedad de plataformas. De esa manera los drivers no se deben escribir directamente para cada Sistema Operativo y el hardware específico de éste sino que se hacen contra el API, que será quién se comunique con el sistema.

OpenGL

OpenGL es una API para el desarrollo de videojuegos y aplicaciones que trabajan con 3D, y actualmente todos los Sistemas Operativos lo soportan, incluido sistemas para dispositivos móviles como Android, que disponen de una versión especifica para sistemas embedidos (OpenGL ES)

Microsoft DirectX

Es la API de Microsoft para el desarrollo de videojuegos, exclusivamente para sus Sistemas Operativos Windows (incluido Windows Phone).

Tarjetas gráficas duales

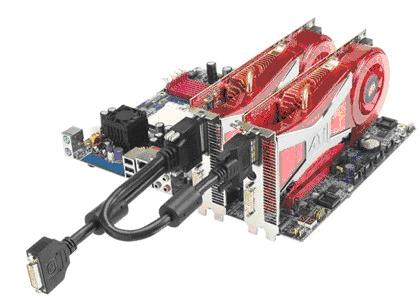

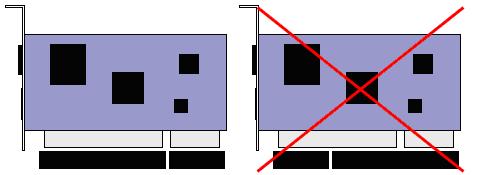

Actualmente, algunos fabricantes como Nvidia y ATI (adquirida recientemente por AMD), han desarrollado tecnología para la conexión de dos tarjetas gráficas en una misma placa base con la finalidad de mejorar el rendimiento gráfico del sistema. Se conocen como Nvidia SLI y AMD CrossFireX

La pantalla

Tamaño

El tamaño de la pantalla viene dada por el tamaño de su diagonal en pulgadas. Actualmente las medidas más habituales van desde los 17“ hasta algo más de 20”. Aunque con el auge del móvil, los netbooks, los ultrabooks y los tablets, existen cada vez más dispositivos con pantallas más pequeñas.

Resolución

La resolución indica la cantidad de detalle que un monitor es capaz de mostrar. Se indica con una medida que expresa el número de pixeles en horizontal y vertical que el monitor es capaz de representar en la pantalla. El total de esa cifra se expresa en megapixeles. Cuanto mayor es la resolución, mayor es el número de pixeles que se emplean en dibujar la misma imagen por lo que se puede apreciar con un detalle mayor.

Con el tiempo la resolución de los monitores ha ido aumentando en la misma medida que aumentaban las prestaciones de las tarjetas gráficas, puesto que son ellas quienes deben ser capaces también de generar la imagen a un nivel de detalle concreto.

Hay que tener en cuenta que hoy en día las tarjetas gráficas son capaces de soportar practicamente cualquier resolución. Son los monitores los que marcan los límites puesto que no todos son capaces de trabajar a todas las resoluciones. En ese sentido, siempre será el monitor quién marque la resolución máxima permitida, por mucho que la tarjeta gráfica sea capaz de soportar mayor nivel de detalle.

En el caso de las pantallas LCD o LED, los monitores están diseñados para trabajar a su resolución nativa. No escalan bien por lo que trabajar con otras resoluciones suelen empeorar la calidad de la imagen. Actualmente han mejorado mucho ambas tecnologías en ese aspecto pero todavía es preferible trabajar con la resolución para la que han sido diseñados.

Relación de aspecto

La relación de aspecto es una medida que mide la relación entre el número de pixeles en horizontal y el número de pixeles en vertical. A lo largo de los últimos años se han utilizado diferentes medidas en cuanto a la relación de aspecto, siendo la más conocido y utilizada casi hasta la actualidad la de 4:3, la misma que se utilizaba en televisión.

En la actualidad, desde la aparición de las pantallas con tecnología LCD o LED la relación de aspecto más extendida ha pasado a ser 16:9, lo que a veces se conoce como formato panorámico.

Pixeles

Un pixel es cada uno de los elementos de imagen en una pantalla, que está formado por tres subpixeles de colores rojo, verde y azul (RGB). Jugando con la intesidad de cada uno de esos subpixeles se generan el color y brillo del pixel desde el color negro hasta el blanco y cualquier color intermedio.

A la hora de elegir un monitor, los valores a tener en cuenta son tamaño y resolución. Así, combinamos ambos se tiene la medida de pixeles por pulgada (ppi, pixels per inch), también conocida como pixel pitch, que mide la distancia en milímetros entre dos pixeles de la pantalla. Esta medida también se conoce como dot pich. Así, cuantos más ppi (o menos pixel pitch), más pequeñas serán las imágenes en la pantalla y, por tanto, más difíciles de leer.

Frecuencia horizontal y vertical

En el caso de pantallas analógicas, la imagen se pinta como una sucesión de líneas de pixeles de izquierda a derecha, y de arriba a abajo. La velocidad a la que esas líneas de pixeles se dibujan en la pantalla es lo que se conoce como frecuencia horizontal y vertical. También se conoce como tasa de refresco. Normalmente los monitores tendrán una tasa de refresco soportada, unos valores máximo y mínimo que indican en el rango de frecuencia que puede trabajar. Así, por un lado hay que tener cuidado con las frecuencias mínimas, sobre todo con la vertical, ya que frecuencias muy bajas pueden producir parpadeo en la pantalla, lo que favorece la vista cansada en el usuario. Por otro lado, una frecuencia superior a la permitida puede forzar la tarjeta gráfica para refrescar más a menudo la imagen.

En la práctica, la frecuencia mínima recomendada es de 75 Hz. Es una frecuencia en la que se elimina el parpadeo y se evitan problemas como vista cansada y dolores de cabeza, y no es demasiado alta de forma que hagamos trabajar en exceso a la tarjeta gráfica. En el caso de los fabricantes de monitores CRT, la frecuencia con la que ellos recomiendan trabajar es de 85 Hz.

Para el caso de pantallas LCD o LED, no se ven tan afectadas por las frecuencias debido a su diseño. Las pantallas LCD utilizan transistores para activar todos los pixeles de la imagen a la vez. Así, en el caso de este tipo de pantallas una tasa de refresco de 60 Hz resulta adecuada (aunque algunas soportan hasta 75 Hz) mientras que para pantallas CRT sería inaceptable para trabajar.

Brillo y contraste

El brillo toma gran importancia en tecnologías como LCD puesto que difiere mucho entre unos modelos y otros. Hay que tener en cuenta que se mide en candelas por metro cuadrado (cd/m2) de forma que cuanto mayor sea la cifra mejor (en torno a 200 y 450 cd/m2)

El contraste se expresa como la relación entre el blanco y el negro, por lo que se recomiendan valores altos. Una de las formas de medirlo es lo que se conoce como el contraste estático, que mide la relación entre el máximo brillo y la oscuridad que se puede producir en una pantalla al mismo tiempo. En algunos casos se indican valores de contraste dinámico en los que influye el tiempo y que genera valores más altos, por lo que resulta una forma de medirlo más confusa. Actualmente unos valores óptimos de contraste estático estarían desde 400:1 a 1500:1. Por encima de esos valores se producen ligeras diferencias casi imperceptibles por lo que conviene más buscar una buena combinación entre brillo y contraste que un valor demasiado alto de contraste.

Almacenamiento

IDE, ATA, SCSI

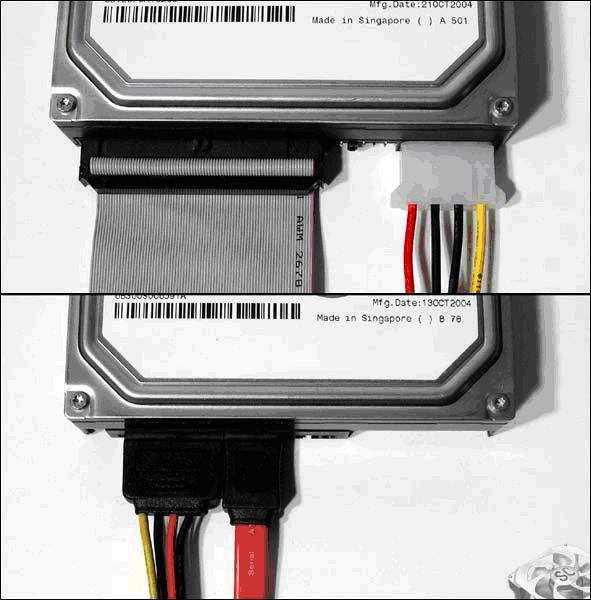

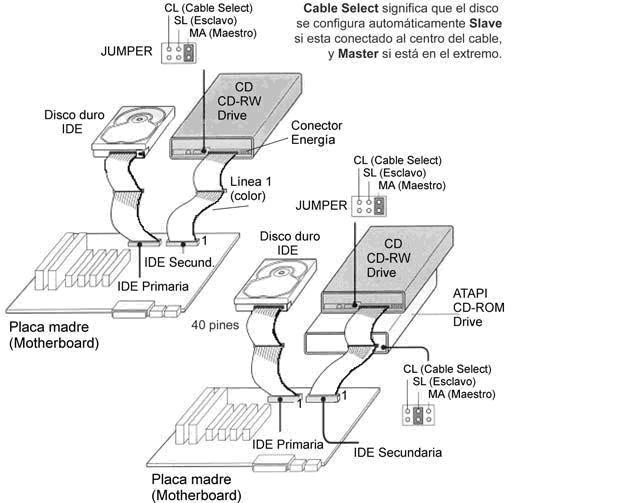

La denominación IDE (ATA o PATA) hace referencia a una tecnología utilizada para conectar dispositivos de almacenamiento (discos duros, CD-ROM, DVD-ROM, . . .) a la placa base del ordenador. El interfaz IDE es un interfaz de conexión en paralelo (Ver tipos de buses) que actualmente ha caído en desuso por la aparición del interfaz SATA.

Por otro lado, los dispositivos de almacenamiento SCSI, también conectados mediante un interfaz paralela muy similar a la de los IDE pero a través de una controladora más potente que los primeros, también se han visto reemplazados por la aparición del protcolo SAS (Serial Attached SCSI). SAS es una versión serie SCSI que, así como ha ocurrido con el paso de IDE a SATA, ha mejorado mucho el rendimiento de este bus, dedicado casi exclusivamente a equipos servidor.

Bus ATA

El estándar ATA (Advanced Technology Attachment) es una interfaz que permite conectar distintos periféricos de almacenamiento a equipos informáticos.

A pesar del nombre oficial ATA, este estándar es más conocido por el término comercial IDE (Integrated device Electronics) o IDE Mejorado (EIDE o E-IDE).

El estándar ATA fue diseñado originalmente para conectar discos duros; sin embargo, se desarrolló una extensión llamada ATAPI (Paquete de Interfaz ATA) que permite interconectar otros periféricos de almacenamiento (unidades de CD-ROM, unidades de DVD-ROM, etc.) en una interfaz ATA. Dado que ha surgido el estándar Serial ATA (escrito S-ATA o SATA), lo que le permite la transferencia de datos a través de un vínculo serial, en algunos casos el término Parallel ATA (escrito PATA o P-ATA) reemplaza al término ATA para diferenciar entre los dos estándares.

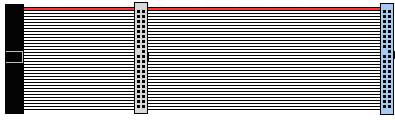

El estándar ATA permite conectar periféricos de almacenamiento de manera directa con la placa madre mediante un cable de cinta, generalmente compuesto de 40 alambres paralelos y tres conectores (usualmente un conector azul para la placa madre y uno negro y otro gris para los dos periféricos de almacenamiento).

En el cable, se debe establecer uno de los periféricos como cable maestro y el otro como esclavo. Por norma, se establece que el conector lejano (negro) se reserva para el periférico maestro y el conector del medio (de color gris) se destina al periférico esclavo. Un modo llamado selección de cable (abreviado CS o C/S) permite definir automáticamente el periférico maestro y el esclavo.

Para aumentar el rendimiento de los datos, puede parecer lógico aumentar la frecuencia de señal del reloj. Sin embargo, en una interfaz donde los datos se envían en paralelo, el aumento de la frecuencia ocasiona problemas de interferencia electromagnética.

De este modo, Ultra DMA (en algunos casos abreviado UDMA) fue diseñado con el fin de optimizar al máximo la interfaz ATA. El primer concepto de Ultra DMA aumentó de la velocidad en un 100% (con un aumento del rendimiento de 16,6 Mbps a 33,3 Mbps). Además, Ultra DMA incorpora el uso de códigos CRC que permiten la detección de errores de transmisión. Por lo tanto, los diferentes modos Ultra DMA definen la frecuencia de la transferencia de datos. Se llegaron a tasas de transferencia de 167 MBps en Ultra DMA 7.

Bus SCSI

El estándar SCSI (Small Computers System Interface) es una interfaz que se utiliza para permitir la conexión de distintos tipos de periféricos a un ordenador mediante una tarjeta denominada adaptador SCSI o controlador SCSI (generalmente mediante un conector PCI).

El número de periféricos que se pueden conectar depende del ancho del bus SCSI. Con un bus de 8 bits, se pueden conectar 8 unidades físicas y con uno de 16 bits, 16 unidades

Actualmente ha aparecido el bus SAS (Serial Attached SCSI) que sustituirá al actual SCSI consiguiendo velocidades de hasta 6 Gbps y se prevee sacar una nueva revisión que conseguirá llegara a las 12 Gbps. Se trata de un bus serie al contrario que el bus SCSI que era un bus paralelo. Además utiliza los mismos conectores que los dispositivos SATA.

SATA (eSATA), SAS

Desde hace unos, el interfaz de conexión y comunicación de los dispositivos de almacenamiento ha pasado de IDE a SATA y de SCSI a SAS. El cambio más notable ha sido el paso de comunicaciones basadas en buses paralelos al uso de buses serie en ambos casos, consiguiendo con ellos un incremento notable en la velocidad de transferencia.

Además, más recientemente se está extendiendo el uso de un nuevo conector externo para dispositivos SATA (e-SATA, external SATA) dada su características de hot-plug (conexión en caliente) tal y como ocurre con el bus USB.

Bus SATA

Serial ATA (S-ATA o SATA) es un bus que permite conectar periféricos de alta velocidad a equipos.

El estándar Serial ATA se introdujo en 2003 con el fin de compensar las limitaciones del estándar ATA que utiliza un modo de transmisión paralelo.

El estándar Serial ATA se basa en una comunicación en serie. Se utiliza una ruta de datos para transmitir los datos y otra ruta para transmitir las confirmaciones de recepción.

Por lo tanto, la comunicación requiere de dos rutas de transmisión, cada una de las cuales está compuesta por dos hilos, con un total de cuatro hilos utilizados para la transmisión.

El cable utilizado por el estándar ATA Serial es un cable redondeado que contiene 7 hilos con un conector de 8 mm en su extremo:

El estándar Serial ATA proporciona una velocidad de 187,5 MBps (1,5 Gbps) y cada octeto se transmite con un bit de arranque y un bit de parada, con una velocidad efectiva teórica de 150 MBps (1,5 Gbps). El estándar Serial ATA II alcanza 300 MBps (3 Gbps), es decir, una velocidad efectiva de 300 MBps, y finalmente Serial ATA III alcanza 600 MBps (6 Gbps), es decir, una velocidad efectiva de 600 MBps.

Los cables del estándar Serial ATA pueden medir hasta 1 metro de longitud (en comparación con los 45 cm que miden los cables IDE). Además, la baja cantidad de hilos en una envoltura redonda permite una mayor flexibilidad y una mejor circulación del aire dentro de la carcasa que la de los cables IDE (incluso si existieran los cables IDE redondeados). A diferencia de los periféricos del estándar ATA, los del Serial ATA se encuentran solos en cada cable y ya no es necesario diferenciar los periféricos maestros de los periféricos esclavos.

Además, el estándar Serial ATA permite la conexión en caliente.

Actualmente también comienza a usarse una versión externa del bus SATA conocida como eSATA, que permite utilizar dispositivos SATA externos bajo las prestaciones de dicho bus.

Bus SAS

También conocido como Serial Attached SCSI es un bus serie que ha reemplazado actualmente al bus paralelo SCSI para la inteconexión de dispositivos de almacenamiento con la placa base, dedicado casi exclusivamente a ordenadores de alto rendimiento en servidores.

En su primera versión ofrecía una velocidad de 3 Gbps que pasaron a 6 Gbps en la primera revisión de esta tecnología. Actualmente está en proceso una mejora para conseguir alcanzar los 12 Gbps.

Sus principales características, en comparación con la antigua tecnología SCSI, son: